预约演示

更新于:2026-02-27

Articaine Hydrochloride/Epinephrine Bitartrate

盐酸阿替卡因/重酒石酸肾上腺素

更新于:2026-02-27

概要

基本信息

药物类型 小分子化药 |

别名 Articaine Hydrochloride and Epinephrine Tartrate、Compound Articaine Hydrochloride、复方盐酸阿替卡因 + [8] |

作用方式 激动剂、调节剂 |

作用机制 ADRA1激动剂(肾上腺素能受体α-1家族激动剂)、SCNA调节剂(钠通道α亚基家族调节剂)、β-adrenoceptors激动剂(β-肾上腺素能受体家族激动剂) |

治疗领域 |

在研适应症 |

非在研适应症 |

原研机构 |

非在研机构- |

权益机构- |

最高研发阶段批准上市 |

首次获批日期 德国 (1976-01-01), |

最高研发阶段(中国)批准上市 |

特殊审评- |

登录后查看时间轴

结构/序列

分子式C13H21ClN2O3S |

InChIKeyGDWDBGSWGNEMGJ-UHFFFAOYSA-N |

CAS号23964-57-0 |

查看全部结构式(2)

关联

24

项与 盐酸阿替卡因/重酒石酸肾上腺素 相关的临床试验NCT07231614

Anesthetic Effectiveness of Lidocaine Versus Articaine in Dentistry. A Randomized Clinical Trial

Context: Lidocaine and articaine are two of the most commonly used local anesthetics in dentistry. Lidocaine has often been the anesthetic of choice in clinical practice, but in clinical experience, articaine has proven to be more effective in controlling pain during dental procedures. (Camps-Font, O. et al. 2020).

There are still unanswered questions, such as which of the two local anesthetics is more effective in reducing pain? This could lead us to discuss which one to choose to reduce costs in the dental office.

Objective: The objective of this project is to determine and compare the effectiveness of lidocaine and articaine in clinical contexts such as tooth extraction with infiltrative techniques, seeking to provide answers that will optimize the choice of anesthetic based on the patient and the procedure, thus improving pain management and reducing costs in the dental office.

Design: Randomized double-blind experimental study, parallel groups. The control group received 2% lidocaine, and the experimental group received 4% articaine. The study will be conducted in accordance with the guidelines of the Consolidated Standards of Reporting Trials (CONSORT 2010). The probabilistic sampling technique is through simple randomization. The 100 patients who meet the inclusion criteria will be randomly assigned to the control and experimental groups in a 1:1 ratio.

Expected results: articaine shows a lower percentage of extractions with anesthetic reinforcement and, therefore, a lower average number of additional tubes.

There are still unanswered questions, such as which of the two local anesthetics is more effective in reducing pain? This could lead us to discuss which one to choose to reduce costs in the dental office.

Objective: The objective of this project is to determine and compare the effectiveness of lidocaine and articaine in clinical contexts such as tooth extraction with infiltrative techniques, seeking to provide answers that will optimize the choice of anesthetic based on the patient and the procedure, thus improving pain management and reducing costs in the dental office.

Design: Randomized double-blind experimental study, parallel groups. The control group received 2% lidocaine, and the experimental group received 4% articaine. The study will be conducted in accordance with the guidelines of the Consolidated Standards of Reporting Trials (CONSORT 2010). The probabilistic sampling technique is through simple randomization. The 100 patients who meet the inclusion criteria will be randomly assigned to the control and experimental groups in a 1:1 ratio.

Expected results: articaine shows a lower percentage of extractions with anesthetic reinforcement and, therefore, a lower average number of additional tubes.

开始日期2025-12-20 |

申办/合作机构 |

NCT06927726

Assessment of Anesthetic Efficacy and Hemodynamic Stability of 4% Articaine (1:100,000 Epinephrine) Versus 3% Mepivacaine Used in Maxillary Teeth Extraction for Hypertensive Patients: A Double-blind Randomized Clinical Study

Pain control in dentistry is an important factor for reducing the fear and anxiety associated with dental procedures. For tooth extraction, it is mandatory to use resources to manage pain and discomfort such as adequate anesthetic techniques . Patient's systemic health conditions and type of local anesthetic drug used, in addition to duration and extension of the extraction procedure are factors which can influence the management of pain in tooth extractions .

Tooth extractions can cause morbidity and changes in hemodynamic parameters to the patient; therefore, it is paramount to carefully select a local anesthetic drug to minimize adverse events . There are a variety of local anesthetics drugs which can meet the specific requirements of different clinical procedures, among them 4% articaine chloridrate with epinephrine at a ratio of 1:100,000. and with and 3% mepivacaine chloridrate without epinephrine, which are largely used in the dental practice and whose clinical safety has already been tested and proved elsewhere

Tooth extractions can cause morbidity and changes in hemodynamic parameters to the patient; therefore, it is paramount to carefully select a local anesthetic drug to minimize adverse events . There are a variety of local anesthetics drugs which can meet the specific requirements of different clinical procedures, among them 4% articaine chloridrate with epinephrine at a ratio of 1:100,000. and with and 3% mepivacaine chloridrate without epinephrine, which are largely used in the dental practice and whose clinical safety has already been tested and proved elsewhere

开始日期2025-01-10 |

申办/合作机构 |

NCT07145879

Differences in Soft Tissue Healing and Vascularization Between Articaine and Lidocaine: A Randomized Clinical and Ultrasonographic Study

The aim of this study is to compare and evaluate the effects of using lidocaine 2% (with adrenaline) and articaine 4% (with adrenaline) in free gingival graft (FGG) surgery on postoperative wound healing, changes in blood flow in the surgical area during the healing process, patients' postoperative pain levels, and anxiety levels before and after surgery.

开始日期2025-01-01 |

申办/合作机构 |

100 项与 盐酸阿替卡因/重酒石酸肾上腺素 相关的临床结果

登录后查看更多信息

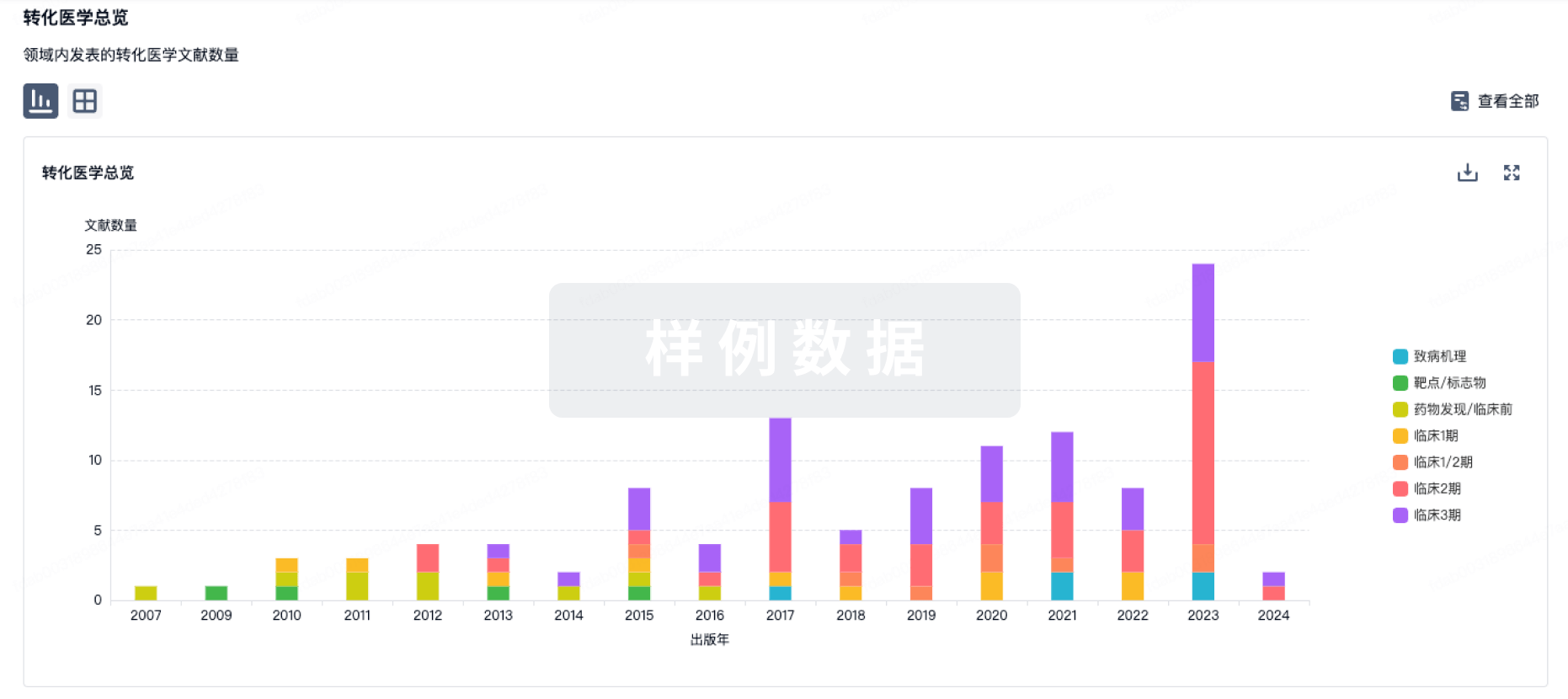

100 项与 盐酸阿替卡因/重酒石酸肾上腺素 相关的转化医学

登录后查看更多信息

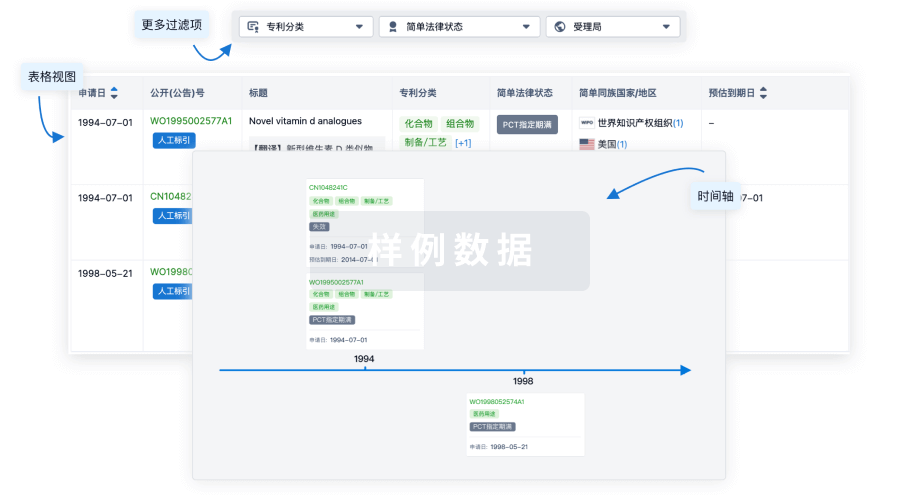

100 项与 盐酸阿替卡因/重酒石酸肾上腺素 相关的专利(医药)

登录后查看更多信息

34

项与 盐酸阿替卡因/重酒石酸肾上腺素 相关的文献(医药)2022-06-01·Journal of the Taiwan Institute of Chemical Engineers3区 · 工程技术

Synergistic deciphering of bioenergy production and electron transport characteristics to screen traditional Chinese medicine (TCM) for COVID-19 drug development

3区 · 工程技术

Article

作者: Chen, Bor-Yann ; Tsai, Po-Wei ; Lee, Chia-Jung ; Lien, Tzu-Kuan ; Ciou, Yi-Ru ; Hsieh, Cheng-Yang ; Hsueh, Chung-Chuan ; Hsieh, Chieh-Lun ; Ting, Jasmine U

Background:

Traditional Chinese medicine (TCM) has been used as an "immune booster" for disease prevention and clinical treatment since ancient China. However, many studies were focused on the organic herbal extract rather than aqueous herbal extract (AHE; decoction). Due to the COVID-19 pandemics, this study tended to decipher phytochemical contents in the decoction of herbs and derived bioactivities (e.g., anti-oxidant and anti-inflammatory properties). As prior works revealed, the efficacy of Parkinson's medicines and antiviral flavonoid herbs was strongly governed by their bioenergy-stimulating proficiency.

Methods:

Herbal extracts were prepared by using a traditional Chinese decoction pot. After filtration and evaporation, crude extracts were used to prepare sample solutions for various bioassays. The phytochemical content and bioactivities of AHEs were determined via ELISA microplate reader. Microbial fuel cells (MFCs) were used as a novel platform to evaluate bioenergy contents with electron-transfer characteristics for antiviral drug development.

Significant findings:

Regarding 18 TCM herbal extracts for the prevention of SARS and H1N1 influenza, comparison on total polyphenol, flavonoid, condensed tannins and polysaccharides were conducted. Moreover, considerable total flavonoid contents were detected for 11 herb extracts. These AEHs were not only rich in phytonutrient contents but also plentiful in anti-oxidant and anti-inflammatory activities. Herbs with high polyphenol content had higher antioxidant activity. Forsythia suspensa extract expressed the highest inhibition against nitric oxide production for anti-inflammation. MFC bioenergy-stimulating studies also revealed that top ranking COVID-19 efficacious herbs were both bioenergy driven and electron mediated. That is, electron transfer-controlled bioenergy extraction was significant to antiviral characteristics for anti-COVID-19 drug development.

2020-01-01·Nanotheranostics

Effects of molecular weight and structural conformation of multivalent-based elastin-like polypeptides on tumor accumulation and tissue biodistribution

Article

作者: Kim, Sang Kyoon ; Seo, Bo-Yeon ; Sarangthem, Vijaya ; Park, Rang-Woon ; Cheon, Sun-Ha ; Lee, Byung-Heon ; Lee, Young-Jin ; Yi, Aena ; Singh, Thoudam Debraj

In order to improve clinical outcomes for novel drug delivery systems, distinct optimization of size, shape, multifunctionality, and site-specificity are of utmost importance. In this study, we designed various multivalent elastin-like polypeptide (ELP)-based tumor-targeting polymers in which multiple copies of IL-4 receptor (IL-4R)-targeting ligand (AP1 peptide) were periodically incorporated into the ELP polymer backbone to enhance the affinity and avidity towards tumor cells expressing high levels of IL-4R. Several ELPs with different molecular sizes and structures ranging from unimer to micelle-forming polymers were evaluated for their tumor accumulation as well as in vivo bio-distribution patterns. Different percentages of cell binding and uptake were detected corresponding to polymer size, number of targeting peptides, or unimer versus micelle structure. As compared to low molecular weight polypeptides, high molecular weight AP1-ELP showed superior binding activity with faster entry and efficient processing in the IL-4R-dependent endocytic pathway. In addition, in vivo studies revealed that the high molecular weight micelle-forming AP1-ELPs (A86 and A100) displayed better tumor penetration and extensive retention in tumor tissue along with reduced non-specific accumulation in vital organs, when compared to low molecular weight non-micelle forming AP1-ELPs. It is suggested that the superior binding activities shown by A86 and A100 may depend on the multiple presentation of ligands upon transition to a micelle-like structure rather than a larger molecular weight. Thus, this study has significance in elucidating the different patterns underlying unimer and micelle-forming ELP-mediated tumor targeting as well as the in vivo biodistribution.

2018-01-01·Asia Oceania journal of nuclear medicine & biology

Comparison of Treatment Response Achieved by Tablet Splitting Versus Whole Tablet Administration of Levothyroxine in Patients with Thyroid Cancer.

Article

作者: Sadeghi, Ramin ; Ashrafpour, Ramin ; Ayati, Narjess ; Zare Namdar, Samira ; Ghahremani, Somayyeh ; Ayati, Nayyereh ; Zakavi, Seyed Rasoul

OBJECTIVES:

TSH suppression by Levothyroxine consumption is a mainstay of thyroid cancer treatment. Tablet-splitting is a worldwide approach in dose adjustment in patients. However, it is highly recommended to evaluate the validity of tablet splitting for each distinctive drug by clinical trials before routinely using tablet halves in clinical practice. In this study we compared the effect of 150 µg dose of Levothyroxine by use of a100 and a 50 µg tablets or one and half 100 µg tablets in Differentiated thyroid cancer (DTC) patients.

METHODS:

One hundred DTC patients treated with one and half 100 µg Levothyroxine tablets were randomly divided into two groups. The first group continued taking medication as before and the second group received the same daily dose by taking one 100 and one 50 microgram Levothyroxine tablets. The mean changes in TSH and T3 levels and patients weight were compared between the groups.

RESULTS:

91 patients completed the study. Levothyroxine consumption pattern, age, gender distribution, weight and TSH levels were comparable between groups at the beginning of the study. The mean change of body weights, serum levels of T3 and TSH showed no significant difference between groups in different time points during the study (P>0.05).

CONCLUSION:

This study showed similar efficacy of tablet splitting and two tablets administration for Levothyroxine; however, patients preferred two tablets at the end of the study. It can be concluded that tablet splitting can be used as an alternative way when the 50 µg tablet is not available.

53

项与 盐酸阿替卡因/重酒石酸肾上腺素 相关的新闻(医药)2026-02-18

·动脉网

Landmark VIVID-2 data showed more than 90% of patients who achieved steroid-free remission at one year maintained steroid-free control through three years 具有里程碑意义的VIVID-2数据显示,超过90%的患者在一年内实现了无类固醇缓解,并在三年内保持了无类固醇控制。Additional new data revealed exceptionally low surgery and hospitalization rates in Omvoh-treated patients across both Crohn's disease and ulcerative colitis (UC), underscoring its potential to fundamentally change disease trajectory 额外的新数据显示,接受Omvoh治疗的克罗恩病和溃疡性结肠炎(UC)患者的手术率和住院率极低,凸显了其从根本上改变疾病进程的潜力。Omvoh now stands alone as the only IL-23p19 inhibitor to show strong and durable efficacy with simple, consistent monthly dosing over four years in UC and three years in Crohn's disease Omvoh 现在是唯一一个在溃疡性结肠炎(UC)四年和克罗恩病三年中,通过简单一致的每月一次给药,展现出强大且持久疗效的IL-23p19抑制剂。INDIANAPOLIS 印第安纳波利斯, ,Feb. 19, 2026 2026年2月19日/PRNewswire/ -- New long-term data from /PRNewswire/ -- 新的长期数据来自Eli Lilly and Company 礼来公司(NYSE: LLY) showed Omvoh (mirikizumab-mrkz) delivered durable efficacy through three years in adults with moderately to severely active Crohn's disease. (NYSE: LLY) 显示,Omvoh(mirikizumab-mrkz)在中度至重度活动性克罗恩病成人患者中三年内持续有效。1 1These data from the Phase 3 VIVID-2 open-label extension study were presented at the 21st 这些来自第 3 阶段 VIVID-2 开放标签扩展研究的数据在第 21 届Congress 国会of the European Crohn's and 欧洲克罗恩病和Colitis Organisation 结肠炎组织(ECCO) in (ECCO) 在Stockholm 斯德哥尔摩. Additional data presented from the Phase 3 VIVID-1 (Crohn's disease) and LUCENT-3 (UC) clinical trials showed Omvoh-treated patients experienced minimal hospitalizations and surgeries across both major types of inflammatory bowel disease (IBD). 来自三期VIVID-1(克罗恩病)和LUCENT-3(溃疡性结肠炎)临床试验的更多数据显示,接受Omvoh治疗的患者在两种主要炎症性肠病(IBD)中住院和手术的情况极少。2,3 2,3Omvoh is the first and only IL-23p19 inhibitor to show strong and durable efficacy over four years in UC and three years in Crohn's disease, with proven reduction of disease complications. Omvoh 是首个也是唯一一个在溃疡性结肠炎(UC)中展现四年强效持久疗效、在克罗恩病中展现三年强效持久疗效的 IL-23p19 抑制剂,并已证明可减少疾病并发症。'Too many people with inflammatory bowel disease never achieve lasting remission, leaving them vulnerable to cumulative damage from poorly controlled inflammation that can result in emergency hospitalizations or surgery,' said “太多炎症性肠病患者从未获得持久的缓解,这使他们容易受到控制不佳的炎症造成的累积损害,从而可能导致紧急住院或手术,”Adrienne Brown 阿德里安娜·布朗, executive vice president and president of Lilly Immunology. 'Omvoh is redefining what durable disease control can look like, with long-term data showing patients treated with Omvoh stayed in remission and experienced fewer serious complications over three years, underscoring its potential to alter the course of the disease.' . ,执行副总裁兼礼来免疫学总裁。'Omvoh正在重新定义持久疾病控制的可能性,长期数据显示,使用Omvoh治疗的患者在三年内保持缓解,并经历了较少的严重并发症,凸显了其改变疾病进程的潜力。'Long-Term Remission and Bowel Urgency Improvements in Crohn's Disease 克罗恩病的长期缓解与肠道紧迫感改善In VIVID-2, patients who achieved an endoscopic response at one year with Omvoh in the Phase 3 VIVID-1 clinical trial experienced long-term efficacy, with the majority remaining in clinical and corticosteroid-free remission and sustaining bowel urgency improvements through three years of continuous Omvoh treatment.. 在VIVID-2试验中,参与3期VIVID-1临床试验的患者在使用Omvoh一年后达到内镜应答,并表现出长期疗效。大多数患者在连续三年使用Omvoh治疗期间保持临床缓解且无需使用皮质类固醇,同时肠道紧迫感的改善也得以维持。1 1Efficacy results at 152 weeks* 152周时的疗效结果* Clinical remission 临床缓解† †92.4 % 92.4 %Corticosteroid-free clinical remission 无皮质类固醇临床缓解‡ ‡91.2 % 91.2 %≥3-point reduction on the Urgency ≥3点的紧迫性降低Numeric Rating Scale (UNRS) 数字评分量表 (UNRS)§ §82.1 % 82.1 %UNRS ≤2 联合国决议 ≤2¶ ¶71.7 % 71.7 %* Among patients who achieved each specified outcome at Week 52 in VIVID-1 and continued treatment in the * 在VIVID-1研究中,第52周达到每个特定结果的患者中,继续接受治疗的VIVID-2 extension; observed cases. These data were also evaluated using a modified non-responder imputation VIVID-2 扩展;观察到的病例。这些数据还使用了改良的无应答者填补方法进行了评估。(mNRI), presented in the About VIVID Clinical Trial Program section below. (mNRI),在下面的关于VIVID临床试验计划部分中提出。† Crohn's Disease Activity Index (CDAI) total score <150. 克罗恩病活动指数(CDAI)总分 <150。‡ CDAI score <150 with no corticosteroid use for prior 12 weeks. CDAI评分<150且前12周未使用皮质类固醇。§ UNRS is the patient-centric scale of 0-10 that evaluates bowel urgency severity, with 0 being no bowel urgency § UNRS 是一个以患者为中心的 0-10 级评分量表,用于评估肠道紧迫感的严重程度,其中 0 表示无肠道紧迫感。and 10 being worst possible bowel urgency. 最严重的肠道紧迫感为10。¶ ¶Among patients with baseline UNRS ≥3. 基线 UNRS ≥3 的患者中。'For people with Crohn's disease, unpredictable flares and abdominal pain can persist when remission isn't achieved or sustained. Additionally, ongoing symptoms like urgent trips to the bathroom and fatigue can continue to disrupt daily life when the disease is not adequately controlled,' said “对于克罗恩病患者来说,当病情缓解未能实现或维持时,不可预测的突发症状和腹痛可能会持续存在。此外,当疾病未得到充分控制时,诸如紧急如厕和疲劳等持续症状可能继续扰乱日常生活,”Edward Barnes 爱德华·巴恩斯, M.D. MPH, Associate Professor of Medicine, 医学博士,公共卫生硕士,医学副教授,University of North Carolina at Chapel Hill 北卡罗来纳大学教堂山分校. 'Seeing more than 90% of patients maintain steroid-free remission through three years on consistent monthly dosing, with 80% also experiencing relief from the disruptive symptoms of bowel urgency, gives providers confidence in Omvoh for outcomes that can last.' “在持续每月一次的用药情况下,看到超过90%的患者在三年内保持无类固醇缓解,其中80%的患者还经历了肠道急迫症状的缓解,这使医生对Omvoh的持久疗效充满信心。”These new long-term Crohn's disease data also showed Omvoh-treated patients who achieved endoscopic response at one year experienced sustained improvement in inflammation, as measured by the continued decrease in inflammatory biomarkers (C-reactive protein and fecal calprotectin) up to three years. 这些新的克罗恩病长期数据还显示,接受奥姆沃治疗的患者在一年时达到内镜应答后,炎症持续改善,这可以通过炎性生物标志物(C反应蛋白和粪便钙卫蛋白)持续减少长达三年来衡量。1 1The long-term safety profile in patients with moderately to severely active Crohn's disease was consistent with the known safety profile of Omvoh. Common adverse events reported from the end of year one through the end of year three (≥5% of Omvoh-treated patients who achieved endoscopic response at one year) included COVID-19, nasopharyngitis, and upper respiratory tract infection.. 中度至重度活动性克罗恩病患者的长期安全性特征与Omvoh的已知安全性特征一致。从第一年结束到第三年结束报告的常见不良事件(≥5%的在一年时达到内镜下应答的Omvoh治疗患者)包括COVID-19、鼻咽炎和上呼吸道感染。1 1Consistently Low Rates of Severe Disease‑Related Complications in IBD IBD中持续较低的严重疾病相关并发症发生率Complementing the three-year Crohn's disease results, additional post hoc data presented from the VIVID-1 (Crohn's disease) and LUCENT-3 (UC) clinical trials showed patients treated with Omvoh experienced consistently low rates of severe disease-related complications. In VIVID-1, Omvoh reduced Crohn's disease-related hospitalizations and/or surgeries by nearly half versus placebo in the first 12 weeks (incidence rate: 16.9 vs. 补充三年克罗恩病结果的还有来自 VIVID-1(克罗恩病)和 LUCENT-3(溃疡性结肠炎)临床试验的更多事后数据显示,接受 Omvoh 治疗的患者严重疾病相关并发症的发生率始终较低。在 VIVID-1 中,与安慰剂相比,Omvoh 在前 12 周内使克罗恩病相关的住院和/或手术减少了近一半(发生率:16.9 vs.30.9 per 100 patient-years), and by nearly 70% during weeks 12 to 52 (4.5 vs. 14.0*).. 每100患者年30.9例),在第12至52周之间降低了近70%(4.5 vs. 14.0*)。2 2In LUCENT-3, one UC-related hospitalization and no UC-related surgeries were reported by patients treated with Omvoh during the three-year long-term extension (incidence rates 0.1 and 0 per 100 patient-years, respectively). 在LUCENT-3研究中,接受Omvoh治疗的患者在三年长期延长期期间报告了一次与溃疡性结肠炎相关的住院,且未发生与溃疡性结肠炎相关的手术(发生率分别为0.1和0每100患者年)。3 3* Placebo rates during weeks 12 to 52 only include placebo patients who were in clinical response at week 12. * 第12周至第52周的安慰剂比率仅包括在第12周时处于临床应答状态的安慰剂患者。Together, these findings expand the growing body of long-term data on Omvoh in IBD, building on previously disclosed 这些发现共同扩大了关于Omvoh在IBD中的长期数据,基于此前披露的数据。two-year results 两年结果in Crohn's disease and 克罗恩病和four-year results 四年结果in UC. 在 UC 中。Lilly is advancing combination studies of mirikizumab aimed at delivering breakthrough induction efficacy while maintaining long-term remission and safety. These include studies in UC with eltrekibart ( 礼来公司正在推进mirikizumab的联合研究,旨在实现突破性的诱导疗效,同时保持长期缓解和安全性。这些研究包括在溃疡性结肠炎(UC)中与eltrekibart联合使用的研究(NCT06598943) NCT06598943), a monoclonal antibody that targets neutrophil-driven inflammation, and with LY4268989 (MORF-057) ( ,一种针对中性粒细胞驱动的炎症的单克隆抗体,并与LY4268989(MORF-057)结合(NCT07186101 NCT07186101), an oral α4β7 integrin inhibitor. Lilly is also advancing novel science to uncover the potential of incretins in immunology and has initiated the COMMIT-UC ( ),一种口服的α4β7整合素抑制剂。礼来公司还在推进新的科学发现,以揭示肠促胰岛素在免疫学中的潜力,并已启动了COMMIT-UC(NCT06937086 NCT06937086) and COMMIT-CD ( ) 和 COMMIT-CD (NCT06937099 NCT06937099) trials evaluating the efficacy and safety of mirikizumab used concomitantly with an incretin-based therapy in adults with ulcerative colitis or Crohn's disease who also have obesity or are overweight with at least one weight-related comorbidity. In addition, trials of mirikizumab in pediatric patients are ongoing in UC (. )评估mirikizumab与基于肠促胰岛素疗法联合使用在患有溃疡性结肠炎或克罗恩病且同时存在肥胖或超重并至少有一种体重相关并发症的成人中的疗效和安全性的试验。此外,mirikizumab在儿科患者中的试验正在UC中进行(。NCT05784246 NCT05784246) and Crohn's disease )和克罗恩病(NCT05509777) (NCT05509777). 。Omvoh has received regulatory approvals for the treatment of moderately to severely active UC and moderately to severely active Crohn's disease in adults and has been approved in 47 countries around the world. Omvoh 已获得治疗中度至重度活动性溃疡性结肠炎(UC)和中度至重度活动性克罗恩病的监管批准,适用于成人,并已在全世界47个国家获得批准。About the VIVID Clinical Trial Program 关于VIVID临床试验计划VIVID-1 was a Phase 3 randomized, double-blind, placebo-controlled 52-week study in adults with moderately to severely active Crohn's disease. Patients randomized to Omvoh received Omvoh 900mg by intravenous (IV) infusion at Week 0, Week 4 and Week 8 followed by a maintenance dose of 300mg by subcutaneous injection (SC) at Week 12 and then every 4 weeks (Q4W) for 40 weeks.. VIVID-1 是一项针对中度至重度活动性克罗恩病成年患者的 III 期随机、双盲、安慰剂对照的 52 周研究。随机分配到 Omvoh 组的患者在第 0 周、第 4 周和第 8 周通过静脉 (IV) 注射接受 900mg 的 Omvoh,随后在第 12 周通过皮下注射 (SC) 接受 300mg 的维持剂量,之后每 4 周 (Q4W) 一次,持续 40 周。4 4Participants who completed VIVID-1, including the Week 52 endoscopy, were eligible for VIVID-2. In VIVID-2, the primary objective is to evaluate the long-term effect of Omvoh in clinical remission by CDAI and endoscopic response at Week 52 of treatment in VIVID-2 (totaling 104 weeks of continuous treatment). 完成 VIVID-1 并包括第 52 周内镜检查的参与者有资格参与 VIVID-2。在 VIVID-2 中,主要目标是通过 CDAI 和 VIVID-2 治疗第 52 周的内镜反应,评估 Omvoh 在临床缓解中的长期效果(总计 104 周的连续治疗)。Safety is being assessed from the first dose in VIVID-2.. 从VIVID-2的第一次剂量开始,安全性正在被评估。1 1Using a modified non-responder imputation method, among Omvoh endoscopic responders at year one, 82.8% of patients maintained CDAI clinical remission through three years, 81.1% maintained corticosteroid-free clinical remission, 72.7% maintained clinically meaningful improvement in bowel urgency and 64.0% of patients maintained bowel urgency remission.. 使用改良的无应答者填补法,在第一年的Omvoh内镜应答者中,82.8%的患者在三年内维持了CDAI临床缓解,81.1%维持了无皮质类固醇临床缓解,72.7%维持了在排便紧迫感方面有临床意义的改善,64.0%的患者维持了排便紧迫感的缓解。1 1About the LUCENT Clinical Trial Program 关于LUCENT临床试验计划Omvoh was studied in two Phase 3 clinical trials which evaluated the efficacy and safety of Omvoh in adults with moderately to severely active UC, in both biologic-naïve patients and those who had previously failed biologic or Janus kinase inhibitors (JAKi). The randomized, double‑blind, placebo‑controlled LUCENT‑1 (induction) study included patients with an inadequate response, loss of response, or intolerance to corticosteroids, immunomodulators, biologic therapy, or JAKi, and LUCENT‑2 (maintenance) evaluated continued treatment versus placebo in patients who achieved a clinical response to Omvoh in LUCENT‑1.. Omvoh 在两项 III 期临床试验中进行了研究,评估了 Omvoh 在中度至重度活动性溃疡性结肠炎(UC)成人患者中的疗效和安全性,包括生物制剂初治患者和既往对生物制剂或 Janus 激酶抑制剂(JAKi)治疗失败的患者。随机、双盲、安慰剂对照的 LUCENT-1(诱导)研究纳入了对皮质类固醇、免疫调节剂、生物疗法或 JAKi 反应不足、失去反应或不耐受的患者,而 LUCENT-2(维持)研究则评估了在 LUCENT-1 中对 Omvoh 产生临床反应的患者继续治疗与安慰剂的效果对比。5 5LUCENT-3, the single-arm long-term Phase 3 open-label extension of LUCENT-1 and LUCENT-2, evaluated the efficacy and safety of Omvoh in patients with UC for an additional three years of treatment (up to four years total). LUCENT-3 是 LUCENT-1 和 LUCENT-2 的单臂长期第三阶段开放标签扩展研究,评估了 Omvoh 在 UC 患者中额外三年治疗(总计长达四年)的疗效和安全性。About Omvoh 关于OmvohOmvoh (mirikizumab-mrkz) is an interleukin-23p19 (IL-23p19) antagonist indicated for the treatment of moderately to severely active ulcerative colitis and Crohn's disease in adults. Omvoh selectively targets the p19 subunit of IL-23 and inhibits the IL-23 pathway. Inflammation due to over-activation of the IL-23 pathway plays a critical role in the pathogenesis of inflammatory bowel disease.. Omvoh(mirikizumab-mrkz)是一种白细胞介素-23p19(IL-23p19)拮抗剂,用于治疗中度至重度活动性溃疡性结肠炎和成人克罗恩病。Omvoh选择性靶向IL-23的p19亚基并抑制IL-23通路。IL-23通路过度激活导致的炎症在炎症性肠病的发病机制中起关键作用。6 6Omvoh and its delivery device base are trademarks owned by Omvoh及其输送装置底座是以下公司拥有的商标Eli Lilly and Company 礼来公司. 。Indications and Usage for Omvoh® (mirikizumab-mrkz) (in Omvoh®(mirikizumab-mrkz)的适应症和用法the United States 美国) )Omvoh is an interleukin-23 antagonist indicated for adults with: Omvoh是一种白细胞介素-23拮抗剂,适用于以下情况的成人:Moderately to severely active ulcerative colitis 中度至重度活动性溃疡性结肠炎Moderately to severely active Crohn's disease 中度至重度活动性克罗恩病Important Safety Information for Omvoh (mirikizumab-mrkz) Omvoh(mirikizumab-mrkz)的重要安全信息CONTRAINDICATIONS 禁忌症Omvoh is contraindicated in patients with a history of serious hypersensitivity reaction to mirikizumab-mrkz or any of the excipients. Omvoh 禁用于对 mirikizumab-mrkz 或任何辅料有严重过敏反应史的患者。WARNINGS AND PRECAUTIONS 警告和注意事项Hypersensitivity Reactions 超敏反应Serious hypersensitivity reactions, including anaphylaxis during intravenous infusion, have been reported with Omvoh administration. Infusion-related hypersensitivity reactions, including mucocutaneous erythema and pruritus, were reported during induction. If a severe hypersensitivity reaction occurs, discontinue Omvoh immediately and initiate appropriate treatment.. 据报道,使用奥姆沃(Omvoh)可能会引发严重的超敏反应,包括静脉输注期间的过敏反应。在诱导期曾报告过与输注相关的超敏反应,包括黏膜皮肤红斑和瘙痒。如果发生严重超敏反应,应立即停止使用奥姆沃,并开始适当的治疗。Infections 感染Omvoh may increase the risk of infection. Do not initiate treatment with Omvoh in patients with a clinically important active infection until the infection resolves or is adequately treated. In patients with a chronic infection or a history of recurrent infection, consider the risks and benefits prior to prescribing Omvoh. Omvoh可能会增加感染风险。在患者有临床重要的活动性感染时,不要开始使用Omvoh治疗,直至感染消退或得到适当治疗。对于慢性感染或有反复感染史的患者,在开Omvoh处方前应权衡风险和益处。Instruct patients to seek medical advice if signs or symptoms of clinically important acute or chronic infection occur. If a serious infection develops or an infection is not responding to standard therapy, monitor the patient closely and do not administer Omvoh until the infection resolves.. 指导患者如果出现临床重要的急性或慢性感染的体征或症状,应寻求医疗建议。如果发生严重感染或感染对标准治疗无反应,应密切监测患者,并在感染解决之前不要给予Omvoh。Tuberculosis 结核病Evaluate patients for tuberculosis (TB) infection prior to initiating treatment with Omvoh. Do not administer Omvoh to patients with active TB infection. Initiate treatment of latent TB prior to administering Omvoh. Consider anti-TB therapy prior to initiation of Omvoh in patients with a history of latent or active TB in whom an adequate course of treatment cannot be confirmed. 在使用Omvoh治疗前,评估患者是否感染结核病(TB)。不要对活动性结核病患者使用Omvoh。在给予Omvoh前,开始治疗潜伏性结核病。对于有潜伏性或活动性结核病史且无法确认已接受足够疗程的患者,考虑在开始使用Omvoh前进行抗结核治疗。Monitor patients for signs and symptoms of active TB during and after Omvoh treatment. In clinical trials, subjects were excluded if they had evidence of active TB, a history of active TB, or were diagnosed with latent TB at screening.. 在Omvoh治疗期间及之后,监测患者是否有活动性结核病的体征和症状。在临床试验中,如果受试者有活动性结核病的证据、活动性结核病史或在筛查时被诊断为潜伏性结核病,则被排除在外。Hepatotoxicity 肝毒性Drug-induced liver injury in conjunction with pruritus was reported in a clinical trial subject following a longer than recommended induction regimen. Omvoh was discontinued. Liver test abnormalities eventually returned to baseline. Evaluate liver enzymes and bilirubin at baseline and for at least 24 weeks of treatment. 在一项临床试验中,有受试者在使用超过推荐时间的诱导方案后报告了药物性肝损伤并伴有瘙痒。Omvoh被停用,肝功能测试异常最终恢复到基线水平。应在基线时以及治疗至少24周期间评估肝酶和胆红素。Monitor thereafter according to routine patient management. Consider other treatment options in patients with evidence of liver cirrhosis. Prompt investigation of the cause of liver enzyme elevation is recommended to identify potential cases of drug-induced liver injury. Interrupt treatment if drug-induced liver injury is suspected, until this diagnosis is excluded. 此后根据常规患者管理进行监测。对于有肝硬化证据的患者,考虑其他治疗方案。建议及时调查肝酶升高的原因,以识别潜在的药物性肝损伤病例。如果怀疑药物性肝损伤,应中断治疗,直到排除此诊断。Instruct patients to seek immediate medical attention if they experience symptoms suggestive of hepatic dysfunction.. 指导患者如果出现提示肝功能障碍的症状,立即寻求医疗关注。Immunizations 免疫接种Avoid use of live vaccines in patients treated with Omvoh. Medications that interact with the immune system may increase the risk of infection following administration of live vaccines. Prior to initiating therapy, complete all age-appropriate vaccinations according to current immunization guidelines. 避免在使用Omvoh治疗的患者中使用活疫苗。与免疫系统相互作用的药物可能会增加接种活疫苗后感染的风险。在开始治疗前,应根据现行免疫指南完成所有适龄疫苗接种。No data are available on the response to live or non-live vaccines in patients treated with Omvoh.. 目前尚无关于使用Omvoh治疗的患者对活疫苗或非活疫苗反应的数据。ADVERSE REACTIONS 不良反应Most common adverse reactions associated with Omvoh (≥2% of subjects and at a higher frequency than placebo) in ulcerative colitis treatment are upper respiratory tract infections and arthralgia during the induction study (UC-1), and upper respiratory tract infections, injection site reactions, arthralgia, rash, headache, and herpes viral infection during the maintenance study (UC-2). 在溃疡性结肠炎治疗中,与Omvoh相关的最常见不良反应(≥2%的受试者,且发生率高于安慰剂)在诱导研究(UC-1)中为上呼吸道感染和关节痛,在维持研究(UC-2)中为上呼吸道感染、注射部位反应、关节痛、皮疹、头痛和疱疹病毒感染。Most common adverse reactions associated with Omvoh in the Crohn's disease study (CD-1) (≥5% of subjects and at a higher frequency than placebo) are upper respiratory tract infections, injection site reactions, headache, arthralgia, and elevated liver tests.. 在克罗恩病研究(CD-1)中,与Omvoh相关的最常见的不良反应(≥5%的受试者,并且发生频率高于安慰剂组)包括上呼吸道感染、注射部位反应、头痛、关节痛和肝功能测试异常。Omvoh injection is available as a 300 mg/15 mL solution in a single-dose vial for intravenous infusion, and as a 100 mg/mL solution or a 200 mg/2 mL solution in a single dose prefilled pen or prefilled syringe for subcutaneous injection. Refer to the Prescribing Information for dosing information. Omvoh注射剂有300毫克/15毫升溶液,单剂量小瓶装,用于静脉输注;还有100毫克/毫升溶液或200毫克/2毫升溶液,单剂量预填充笔或预填充注射器装,用于皮下注射。有关剂量信息,请参阅处方信息。MR HCP ISI CD APP 先生医疗保健专业人员国际睡眠障碍分类应用Click to access provided 点击以访问提供的内容Prescribing Information 处方信息and 和Medication Guide 药品指南. See Instructions for Use provided with the device. 请参阅设备附带的使用说明。About Lilly 莉莉简介Lilly is a medicine company turning science into healing to make life better for people around the world. We've been pioneering life-changing discoveries for nearly 150 years, and today our medicines help tens of millions of people across the globe. Harnessing the power of biotechnology, chemistry and genetic medicine, our scientists are urgently advancing new discoveries to solve some of the world's most significant health challenges: redefining diabetes care; treating obesity and curtailing its most devastating long-term effects; advancing the fight against Alzheimer's disease; providing solutions to some of the most debilitating immune system disorders; and transforming the most difficult-to-treat cancers into manageable diseases. 礼来是一家医药公司,将科学转化为治疗手段,以改善世界各地人们的生活。近150年来,我们一直在开创改变生命的发现,如今我们的药物帮助了全球数千万人。通过利用生物技术、化学和基因医学的力量,我们的科学家正在加速推进新的发现,以解决一些全球最重要的健康挑战:重新定义糖尿病护理;治疗肥胖症并遏制其最具破坏性的长期影响;推动对抗阿尔茨海默病的斗争;为一些最严重的免疫系统疾病提供解决方案;并将最难治疗的癌症转化为可管理的疾病。With each step toward a healthier world, we're motivated by one thing: making life better for millions more people. That includes delivering innovative clinical trials that reflect the diversity of our world and working to ensure our medicines are accessible and affordable. To learn more, visit . 每朝着更健康的世界迈出一步,我们都受到一个目标的激励:让数百万人的生活变得更好。这包括开展反映世界多样性的创新临床试验,并努力确保我们的药品可及且负担得起。欲了解更多信息,请访问。Lilly.com 莉莉网and 和Lilly.com/news Lilly.com/新闻, or follow us on ,或者关注我们Facebook Facebook, ,Instagram Instagram, and ,以及LinkedIn 领英. P-LLY . P-LLYTrademarks and 商标和Trade Names 商标名称All trademarks or trade names referred to in this press release are the property of the company, or, to the extent trademarks or trade names belonging to other companies are references in this press release, the property of their respective owners. Solely for convenience, the trademarks and trade names in this press release are referred to without the ® and ™ symbols, but such references should not be construed as any indicator that the company or, to the extent applicable, their respective owners will not assert, to the fullest extent under applicable law, the company's or their rights thereto. 本新闻稿中提到的所有商标或商号均为该公司所有,或者,若涉及属于其他公司的商标或商号,则归其各自所有者所有。仅为方便起见,本新闻稿中提及的商标和商号未附带®和™符号,但此类引用不应被解释为表示该公司或在适用情况下其各自所有者不会根据适用法律最大限度地主张公司或其对此类权利的所有权。We do not intend the use or display of other companies' trademarks and trade names to imply a relationship with, or endorsement or sponsorship of us by, any other companies.. 我们无意使用或展示其他公司的商标和商号来暗示我们与其他公司存在关联,或得到其他公司的认可或赞助。Cautionary Statement Regarding Forward-Looking Statements 关于前瞻性陈述的谨慎声明This press release contains forward-looking statements (as that term is defined in the Private Securities Litigation Reform Act of 1995) about Omvoh (mirikizumab-mrkz) as a treatment for people with moderate to severe ulcerative colitis and moderate to severe Crohn's disease and reflects Lilly's current beliefs and expectations. 本新闻稿包含关于Omvoh(mirikizumab-mrkz)用于治疗中度至重度溃疡性结肠炎和中度至重度克罗恩病患者的前瞻性声明(该术语定义见1995年《私人证券诉讼改革法案》),并反映了礼来公司当前的信念和期望。However, as with any pharmaceutical product, there are substantial risks and uncertainties in the process of drug research, development, and commercialization. Among other things, there is no guarantee that planned or ongoing studies will be completed as planned, that future study results will be consistent with study results to date, that Omvoh will receive additional regulatory approvals, or that Omvoh will be commercially successful. 然而,与任何药物产品一样,在药物研发、开发和商业化过程中存在重大风险和不确定性。其中,不能保证计划中或正在进行的研究会按计划完成,未来的研究结果会与迄今为止的研究结果一致,Omvoh 会获得额外的监管批准,或者 Omvoh 会在商业上取得成功。For further discussion of these and other risks and uncertainties that could cause actual results to differ from Lilly's expectations, see Lilly's Form 10-K and Form 10-Q filings with the . 有关可能导致实际结果与礼来公司预期不同的这些风险和其他不确定性的进一步讨论,请参阅礼来公司向美国证券交易委员会提交的Form 10-K和Form 10-Q报告。United States Securities and Exchange Commission 美国证券交易委员会. Except as required by law, Lilly undertakes no duty to update forward-looking statements to reflect events after the date of this release. 除非法律要求,礼来公司没有义务更新前瞻性声明以反映本发布日期之后的事件。References 参考文献1 1Laharie D, et al. P0563 Mirikizumab demonstrated sustained and durable long-term efficacy and favorable safety in week 52 endoscopic responders with Crohn's disease: 3-year VIVID-2 open-label extension interim results. Laharie D, 等。P0563 Mirikizumab 在第52周内镜应答的克罗恩病患者中显示出持续且长期的疗效和良好的安全性:3年VIVID-2开放标签扩展中期结果。Journal of Crohn's and Colitis 《克罗恩病与结肠炎杂志》. 。2026;20(Suppl 1):jjaf231.744. 2026年;20卷(增刊1):jjaf231.744。https://doi.org/10.1093/ecco-jcc/jjaf231.744 https://doi.org/10.1093/ecco-jcc/jjaf231.7442 2Sands B, et al. Mirikizumab treatment reduces Crohn's disease–related surgery and hospitalization rates: analyses from VIVID-1. Sands B, 等。Mirikizumab 治疗可降低克罗恩病相关手术和住院率:来自 VIVID-1 的分析。Journal of Crohn's and Colitis 克罗恩病和结肠炎杂志. 2026;20(Suppl 1):jjaf231.042. . 2026;20(补充 1):jjaf231.042.https://doi.org/10.1093/ecco-jcc/jjaf231.042 https://doi.org/10.1093/ecco-jcc/jjaf231.0423 3Magro F, et al. Mirikizumab treatment decreases ulcerative colitis–related surgery and hospitalisation rates: 4-year LUCENT studies results. Magro F, 等。Mirikizumab 治疗降低溃疡性结肠炎相关手术和住院率:4年 LUCENT 研究结果。Journal of Crohn's and Colitis 《克罗恩病与结肠炎杂志》. 。2026;20(Suppl 1):jjaf231.1300. 2026;20(补充1):jjaf231.1300.https://doi.org/10.1093/ecco-jcc/jjaf231.1300 https://doi.org/10.1093/ecco-jcc/jjaf231.13004 4Ferrante M, et al. Efficacy and safety of mirikizumab in patients with moderately-to-severely active Crohn's disease: a phase 3, multicentre, randomised, double-blind, placebo-controlled and active-controlled, treat-through study. 费兰特 M 等。Mirikizumab 在中度至重度活动性克罗恩病患者中的疗效与安全性:一项三期、多中心、随机、双盲、安慰剂对照和活性对照的贯穿治疗研究。The Lancet 柳叶刀. 2024;404(10470):2423-2436. . 2024;404(10470):2423-2436.5 5Sands, B, et al. Three-year efficacy and safety of mirikizumab following 152 weeks of continuous treatment for ulcerative colitis: results from the LUCENT-3 open-label extension study. Inflammatory Bowel Diseases, 2024;izae253, Sands, B, 等。持续治疗溃疡性结肠炎152周后,mirikizumab的三年疗效与安全性:来自LUCENT-3开放标签扩展研究的结果。《炎症性肠病》,2024年;izae253。https://doi.org/10.1093/ibd/izae253 https://doi.org/10.1093/ibd/izae2536 6Omvoh. Prescribing Information. 奥姆沃。处方信息。Lilly USA, LLC 美国礼来公司. 。Refer to: 参考:Kelly Hoffman 凯莉·霍夫曼; ;kelly.hoffman@lilly.com 凯莉·霍夫曼@礼来公司.com; 765-736-2555 (Lilly media) ;765-736-2555(礼来媒体)Michael Czapar; 迈克尔·查帕尔;czapar_michael_c@lilly.com czapar_michael_c@lilly.com; 317-617-0983 (Investors) ;317-617-0983(投资者)View original content to download multimedia: 查看原始内容以下载多媒体: https://www.prnewswire.com/news-releases/patients-with-crohns-disease-maintained-steroid-free-remission-for-three-years-with-lillys-omvoh-mirikizumab-mrkz-302691766.html https://www.prnewswire.com/news-releases/克罗恩病患者使用礼来的omvoh-mirikizumab-mrkz维持三年无类固醇缓解-302691766.htmlSOURCE 源代码Eli Lilly and Company 礼来公司

临床结果临床3期紧急使用授权临床失败

2026-02-17

·今日头条

中国在2026年产业竞争中的优势,核心是新能源、半导体等领域的技术领先和成本控制,以及全球最完整的产业集群。这些优势不是凭空而来,而是基于过去几年的持续突破和积累。

技术领先与成本控制

在新能源领域,中国已经确立了全球领跑地位。2025年,中国新能源乘用车全球市场份额达到

68.4%

,第四季度更是高达

71.9%

,意味着全球每卖出10辆电动车,超过7辆来自中国。

更关键的是技术代差:宁德时代量产的

第二代凝聚态电池

能量密度达

500Wh/kg

,充电15分钟续航800公里,而特斯拉4680电池能量密度仅296Wh/kg。成本优势同样碾压——中国电池包成本已降至

每千瓦时75美元

,美国本土生产成本则为

135美元

。

这种差距直接决定了全球中低端电动车市场的定价权。

半导体产业也从“卡脖子”转向自主可控。华为通过“南泥湾”项目,旗舰机型零部件国产化率突破

95%

,搭载的麒麟9010芯片采用中芯国际

7nm工艺

实现量产,支撑高端手机全功能。

断供倒逼出创新:华为海思转向RISC-V开源架构,自研AI算力接近国际顶级水平;国产GPU在AI训练任务中性能达到A100的80%,价格仅为其1/3。

产业集群无可替代

跨国企业曾尝试“中国+1”供应链转移,但现实很残酷。越南工业电力成本是中国的

1.8倍

,印度物流效率只有中国的

40%

,墨西哥熟练工人培养周期是中国的

3倍

。以苹果为例,2024年将10%的iPhone生产转移到印度,结果良品率只有

65%

(中国工厂超95%),2025年又悄悄转回深圳。

这背后是中国制造业的深层护城河:

完整的产业协同

:华为产能复苏带动中芯国际、京东方等供应链企业工艺提升,形成“以点带面”的升级效应。

持续的技术迭代

:从传统船舶(占全球**50%**以上订单)到高端制造,中国产业集群能快速适应市场变化。

成熟的供应链网络

:物流、配套、劳动力培养的成熟度,让其他国家难以在短期内复制。

医药创新走向全球

生物医药领域,中国正从“仿制药”转向“原创药”输出。2025年,中国共批准上市创新药

76个

,其中国产FIC(同类第一)新药占比超

80%

。全年License-out(对外授权)交易达

157笔

,总金额

1356.6亿美元

,恒瑞医药与GSK的单笔授权甚至刷新纪录。

企业层面,信达生物、百济神州在2025年分别获得FDA批准的3款和2款新药,实现了国产创新药在美零的突破。例如,信达生物的

达伯欣

是中国首款国产抗CTLA-4单抗,与PD-1组成“双免疫”方案,显著提升结肠癌病理完全缓解率。

这些突破背后是研发投入的飙升:2015-2025年,中国生物医药研发投入从200亿美元增至1200亿美元。

综合来看,中国产业的优势已从规模效应升级为技术、成本和生态的全链条能力,这为2026年的竞争奠定了坚实基础。

上市批准引进/卖出

2026-02-11

·百度百家

有种感觉,暴风雨前的宁静,马上就要被撕开了。有人算了笔账,说快了,大概就2026年,咱们的经济体量,就可能要跟老大掰掰手腕,甚至坐上头把交椅。你以为这只是个数字游戏?不,这是龙椅换人坐的大事。

老大现在彻底不装了。以前贸易战那会儿还天天在电视上喊口号,关税加来加去,现在基本不怎么公开叫板了,改玩暗的。直接掐供应链最要命的几个点。先拿芯片开刀,2022年开始就把高端光刻机、EDA软件、先进制程的设备和材料卡得死死的。ASML那台EUV光刻机,中国大陆一台都拿不到。英伟达最新几代AI芯片也直接禁售,连A100、H100这种以前还能偷偷搞到的,现在渠道全断了。

医药这块也下狠手。2024年美国又把一批生物技术公司和研究机构拉进实体清单,说是涉及所谓“军民融合”。最典型的就是把几家做mRNA和基因编辑的公司直接封了,连带上游的试剂、仪器都受限。摆明就是不想让你在下一代药上面翻身。

地缘上更明显。美国这几年把后院看得特别紧。拉美那几个国家,稍微跟中国走近点,马上就被各种“警告”。2025年年初,美国就跟巴西、阿根廷、智利同时签了好几个所谓“关键矿产安全伙伴关系”,明着说要减少对中国供应链依赖。实际上就是不让中国企业继续大规模拿锂、铜、稀土项目。墨西哥那边更绝,2024年底美国直接施压,把好几个中国新能源车厂的扩建计划卡在审批环节,搞得工厂迟迟动不了工。

全球拉帮结派这事也没停。2023年搞了个“印太经济框架”,2024年又升级成“芯片四方联盟+”,把日韩台澳全塞进来。欧洲那边更狠,2025年欧盟正式通过了《芯片法案2.0》,直接拿补贴砸本土企业,还给中国来的设备加了额外审查。日本前两年已经把23种半导体材料和设备列为出口管制,现在范围又扩大到光刻胶、电子气体这些。中国买都买不到原装货,只能自己慢慢啃。

但他们这套组合拳打下来,自己也疼得龇牙咧嘴。美国自己的芯片厂进度严重滞后。台积电亚利桑那厂2025年投产的还是4纳米,良率低得离谱,成本比台湾高30%以上。英特尔那几条新线也是烧钱机器,2025财年亏损继续扩大。欧洲那边ASML、英飞凌这些公司订单一大半靠中国,禁售之后股价已经跌了两轮。日本的信越化学、JSR这些材料厂,2024年对华出口腰斩,利润直接雪崩。

最扎眼的是新能源这块。中国的新三样——电动车、锂电池、光伏,确实把全球市场搅得天翻地覆。2025年全年,中国电动车出口突破700万辆,比2024年猛增了近四成。欧洲市场份额已经超过25%,德国、法国好几个传统车企叫苦连天。比亚迪、宁德时代、上汽这些企业在泰国、印尼、巴西、匈牙利都建厂,本地化生产直接绕过关税壁垒。光伏组件全球市场份额稳在80%以上,美国自己装的太阳能板,70%还是中国货。

东南亚和非洲那边反应完全不一样。中国企业过去不是卖产品,是直接带着钱、技术、基建一起去。2025年“一带一路”沿线国家新增了好几个特大项目,印尼的镍铁、刚果的钴铜、越南的电池材料厂,全是中资带头干。那些国家领导人见面都笑得合不拢嘴,说中国不光给钱,还真把工厂建起来了,工作岗位也实打实增加。美国那边光喊口号,给的钱却少得可怜,还一堆政治附加条件,当地人早就烦了。

科技封锁最狠的还是那几块高地。AI大模型训练现在基本被掐住脖子,算力缺口巨大。2025年中国自己算力集群虽然起来了,但顶级GPU还是靠囤货和二手翻新撑着。华为昇腾、海光、壁仞这些国产芯片进步快,但离真正顶尖还有距离。生物医药也是,mRNA疫苗平台、CAR-T疗法这些前沿领域,美国把核心专利和临床数据卡得死死的。

不过话说回来,最硬的底气还是在自己身上。14亿人这个市场,谁都绕不开。2025年国内新能源车渗透率已经冲到48%,光伏装机一年新增超过300吉瓦,全部是内需拉动。老百姓买车、装屋顶电站、换家电,这股消费劲头是实打实的。企业也咬牙往前拱,宁德时代2025年全球市场份额继续扩大到38%,华为在欧洲光伏逆变器卖得比本土企业还好。研发投入一年比一年猛,2025年全社会研发支出预计突破4万亿人民币。

未来这几年肯定不好过。美国和它的几个铁杆盟友铁了心要在科技前沿死磕,尤其AI、量子、生物三大赛道,估计还会出更多黑招。但中国这边也不是光挨打。国产替代已经从“有没有”变成“好不好用”。光伏、电池、电动车已经证明,别人堵得再死,只要方向对、链条齐,自己就能跑出来。

再熬个三五年,很多事就彻底不一样了。现在这些围追堵截,看起来吓人,其实就是上坡路上必须爬的几道坎。跨过去,视野一下就开阔了。前面不是悬崖,是真的一马平川。

信使RNA疫苗

100 项与 盐酸阿替卡因/重酒石酸肾上腺素 相关的药物交易

登录后查看更多信息

外链

| KEGG | Wiki | ATC | Drug Bank |

|---|---|---|---|

| - | - | - |

研发状态

批准上市

10 条最早获批的记录, 后查看更多信息

登录

| 适应症 | 国家/地区 | 公司 | 日期 |

|---|---|---|---|

| 麻醉 | 德国 | 1976-01-01 |

未上市

10 条进展最快的记录, 后查看更多信息

登录

| 适应症 | 最高研发状态 | 国家/地区 | 公司 | 日期 |

|---|---|---|---|---|

| 炎症性疼痛 | 临床前 | 美国 | - | - |

登录后查看更多信息

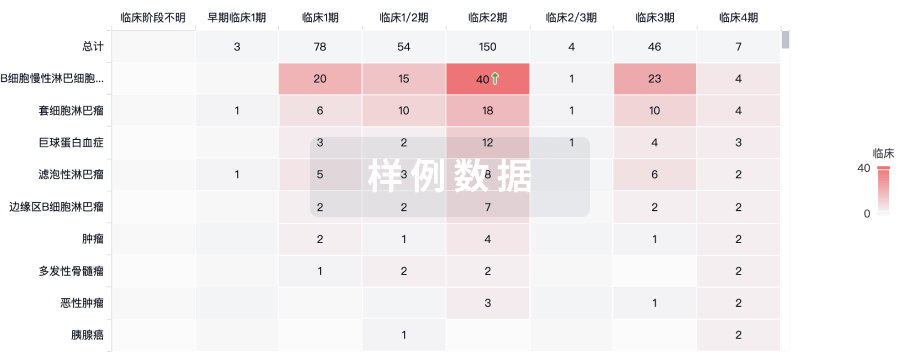

临床结果

临床结果

适应症

分期

评价

查看全部结果

| 研究 | 分期 | 人群特征 | 评价人数 | 分组 | 结果 | 评价 | 发布日期 |

|---|

No Data | |||||||

登录后查看更多信息

转化医学

使用我们的转化医学数据加速您的研究。

登录

或

药物交易

使用我们的药物交易数据加速您的研究。

登录

或

核心专利

使用我们的核心专利数据促进您的研究。

登录

或

临床分析

紧跟全球注册中心的最新临床试验。

登录

或

批准

利用最新的监管批准信息加速您的研究。

登录

或

特殊审评

只需点击几下即可了解关键药物信息。

登录

或

生物医药百科问答

全新生物医药AI Agent 覆盖科研全链路,让突破性发现快人一步

立即开始免费试用!

智慧芽新药情报库是智慧芽专为生命科学人士构建的基于AI的创新药情报平台,助您全方位提升您的研发与决策效率。

立即开始数据试用!

智慧芽新药库数据也通过智慧芽数据服务平台,以API或者数据包形式对外开放,助您更加充分利用智慧芽新药情报信息。

生物序列数据库

生物药研发创新

免费使用

化学结构数据库

小分子化药研发创新

免费使用