预约演示

更新于:2025-12-07

Relay Therapeutics, Inc.

更新于:2025-12-07

概览

标签

肿瘤

皮肤和肌肉骨骼疾病

泌尿生殖系统疾病

小分子化药

化学药

蛋白水解靶向嵌合体(PROTAC)

疾病领域得分

一眼洞穿机构专注的疾病领域

暂无数据

技术平台

公司药物应用最多的技术

暂无数据

靶点

公司最常开发的靶点

暂无数据

| 排名前五的药物类型 | 数量 |

|---|---|

| 小分子化药 | 8 |

| 化学药 | 1 |

| 蛋白水解靶向嵌合体(PROTAC) | 1 |

关联

10

项与 Relay Therapeutics, Inc. 相关的药物作用机制 PIK3CA E542K突变抑制剂 [+2] |

非在研适应症- |

最高研发阶段临床3期 |

首次获批国家/地区- |

首次获批日期- |

靶点 |

作用机制 FGFR2拮抗剂 |

非在研适应症- |

最高研发阶段临床1/2期 |

首次获批国家/地区- |

首次获批日期- |

作用机制 PIK3CA E542K突变抑制剂 [+2] |

非在研适应症- |

最高研发阶段临床1期 |

首次获批国家/地区- |

首次获批日期- |

5

项与 Relay Therapeutics, Inc. 相关的临床试验NCT06982521

A Phase 3 Open-Label Randomized Study Assessing the Efficacy and Safety of RLY-2608 + Fulvestrant Versus Capivasertib + Fulvestrant as Treatment for PIK3CA-mutant Hormone Receptor Positive, Human Epidermal Growth Factor Receptor 2 Negative (HR+/HER2-) Locally Advanced or Metastatic Breast Cancer Following Recurrence or Progression On or After Treatment With a CDK4/6 Inhibitor

This is a global, multicenter, open-label, randomized Phase 3 study comparing the efficacy and safety of RLY-2608 + fulvestrant to capivasertib + fulvestrant for the treatment of patients with HR+/HER2- ABC with PIK3CA mutation following recurrence or progression on or after treatment with a CDK4/6 inhibitor.

开始日期2025-08-26 |

申办/合作机构 |

NCT06789913

A Phase 2 Study of Mutant-selective PI3Kα Inhibitor, RLY-2608, in Adults and Children With PIK3CA Related Overgrowth Spectrum and Malformations Driven by PIK3CA Mutation

This is a 3-part Phase 2 randomized study evaluating the safety and efficacy of the mutant-selective PI3Kα inhibitor, RLY-2608, in adults and children with PIK3CA Related Overgrowth Spectrum (PROS) and malformations driven by PIK3CA mutation. Part 1 is a dose selection, Part 2 is a basket design with exploratory single-arm cohorts for various subpopulations of participants, and Part 3 is randomized, double-blinded study vs placebo.

开始日期2025-06-13 |

申办/合作机构 |

NCT05759949

A First-in-Human Study of PI3Kα Inhibitor, RLY-5836, in Combination With Targeted and Endocrine Therapies in Participants With Advanced Breast Cancer and as a Single Agent in Advanced Solid Tumors

This is a Phase 1, first-in-human, open-label study designed to evaluate the maximum tolerated dose (MTD), recommended phase 2 dose (RP2D), safety, tolerability, pharmacokinetics, pharmacodynamics, and preliminary anti-tumor activity of RLY-5836 in advanced solid tumors in participants harboring a PIK3CA mutation in blood and/or tumor per local assessment. The study consists of 2 parts, a dose escalation (Part 1) and a dose expansion (Part 2).

开始日期2023-03-29 |

申办/合作机构 |

100 项与 Relay Therapeutics, Inc. 相关的临床结果

登录后查看更多信息

0 项与 Relay Therapeutics, Inc. 相关的专利(医药)

登录后查看更多信息

13

项与 Relay Therapeutics, Inc. 相关的文献(医药)2025-09-22·Journal of Chemical Information and Modeling

Practically Significant Method Comparison Protocols for Machine Learning in Small Molecule Drug Discovery

Article

作者: Cheng, Alan C. ; Aldeghi, Matteo ; Clevert, Djork-Arné ; Ash, Jeremy R. ; Price, Daniel J. ; Hughes-Oliver, Jacqueline M. ; Rodríguez-Pérez, Raquel ; Fang, Cheng ; Wognum, Cas ; Engkvist, Ola ; Walters, W. Patrick

Machine Learning (ML) methods that relate molecular structure to properties are frequently proposed as in silico surrogates for expensive or time-consuming experiments. In small molecule drug discovery, such methods inform high-stakes decisions like compound synthesis and in vivo studies. This application lies at the intersection of multiple scientific disciplines. When comparing new ML methods to baseline or state-of-the-art approaches, statistically rigorous method comparison protocols and domain-appropriate performance metrics are essential to ensure replicability and ultimately the adoption of ML in small molecule drug discovery. This paper proposes a set of guidelines to incentivize rigorous and domain-appropriate techniques for method comparison tailored to small molecule property modeling. These guidelines, accompanied by annotated examples using open-source software tools, lay a foundation for robust ML benchmarking and thus the development of more impactful methods.

2025-07-14·Journal of Chemical Information and Modeling

CACHE Challenge #2: Targeting the RNA Site of the SARS-CoV-2 Helicase Nsp13

Article

A critical assessment of computational hit-finding experiments (CACHE) challenge was conducted to predict ligands for the SARS-CoV-2 Nsp13 helicase RNA binding site, a highly conserved COVID-19 target. Twenty-three participating teams comprised of computational chemists and data scientists used protein structure and data from fragment-screening paired with advanced computational and machine learning methods to each predict up to 100 inhibitory ligands. Across all teams, 1957 compounds were predicted and were subsequently procured from commercial catalogs for biophysical assays. Of these compounds, 0.7% were confirmed to bind to Nsp13 in a surface plasmon resonance assay. The six best-performing computational workflows used fragment growing, active learning, or conventional virtual screening with and without complementary deep-learning scoring functions. Follow-up functional assays resulted in identification of two compound scaffolds that bound Nsp13 with a Kd below 10 μM and inhibited in vitro helicase activity. Overall, CACHE #2 participants were successful in identifying hit compound scaffolds targeting Nsp13, a central component of the coronavirus replication-transcription complex. Computational design strategies recurrently successful across the first two CACHE challenges include linking or growing docked or crystallized fragments and docking small and diverse libraries to train ultrafast machine-learning models. The CACHE #2 competition reveals how crowd-sourcing ligand prediction efforts using a distinct array of approaches followed with critical biophysical assays can result in novel lead compounds to advance drug discovery efforts.

2025-05-19·CHEMICAL RESEARCH IN TOXICOLOGY

Machine Learning for Toxicity Prediction Using Chemical Structures: Pillars for Success in the Real World

Review

作者: Badré, Adrien ; Weis, Caroline ; Clevert, Djork-Arné ; Wilk, Deidre Dalmas ; Paisley, Brianna ; Vidler, Lewis R ; Seal, Srijit ; Shekhar, Mrinal ; Richmond, Nicola ; Mansouri, Kamel ; Walters, W. Patrick ; Spjuth, Ola ; Singh, Shantanu ; Joshi, Chaitanya K. ; Rouquie, David ; Bender, Andreas ; Shah, Falgun ; Nicolaou, Christos A. ; Johannesson, Bjarki ; Beatson, Alex ; Patra, Arijit ; Lowe, Rhiannon ; Schramm, Carolin ; Williams, Dominic ; Schwab, Patrick ; Carpenter, Anne E. ; García-Ortegón, Miguel ; Naven, Russell ; Hosseini-Gerami, Layla ; Mahale, Manas ; Gonzalez, Raymond J. ; Mehrjou, Arash ; Greenig, Matthew

Machine learning (ML) is increasingly valuable for predicting molecular properties and toxicity in drug discovery. However, toxicity-related end points have always been challenging to evaluate experimentally with respect to in vivo translation due to the required resources for human and animal studies; this has impacted data availability in the field. ML can augment or even potentially replace traditional experimental processes depending on the project phase and specific goals of the prediction. For instance, models can be used to select promising compounds for on-target effects or to deselect those with undesirable characteristics (e.g., off-target or ineffective due to unfavorable pharmacokinetics). However, reliance on ML is not without risks, due to biases stemming from nonrepresentative training data, incompatible choice of algorithm to represent the underlying data, or poor model building and validation approaches. This might lead to inaccurate predictions, misinterpretation of the confidence in ML predictions, and ultimately suboptimal decision-making. Hence, understanding the predictive validity of ML models is of utmost importance to enable faster drug development timelines while improving the quality of decisions. This perspective emphasizes the need to enhance the understanding and application of machine learning models in drug discovery, focusing on well-defined data sets for toxicity prediction based on small molecule structures. We focus on five crucial pillars for success with ML-driven molecular property and toxicity prediction: (1) data set selection, (2) structural representations, (3) model algorithm, (4) model validation, and (5) translation of predictions to decision-making. Understanding these key pillars will foster collaboration and coordination between ML researchers and toxicologists, which will help to advance drug discovery and development.

292

项与 Relay Therapeutics, Inc. 相关的新闻(医药)2025-12-05

·今日头条

序章:药物发现的“淘金热”与困境

一款新药的诞生,传统上是一场耗时十年、耗资数十亿美元的豪赌。其起点,是从成千上万个候选分子中,通过大量实验筛选出少数几个有潜力的进行后续开发。这个过程如同大海捞针,失败率极高,其中临床前药物发现阶段更是瓶颈所在。化学家们需要合成并测试大量化合物,效率低下且成本高昂。

有没有一种方法,能像用金属探测器在沙滩上找金子一样,在合成之前就预测出哪些分子最有希望?这个想法催生了一个新兴领域——计算机辅助药物设计(CADD)。而将这一理念推向极致,并成功实现商业化的,正是薛定谔公司。

创始人愿景:当物理学家试图改写药学规则

薛定谔公司的故事始于1989年,其联合创始人李普曼(Richard A. Friesner)是一位理论化学和物理学家。他们的核心愿景基于一个基本原理:

分子与靶点蛋白(如疾病相关的酶或受体)的相互作用,是可以通过物理学定律(特别是薛定谔方程)进行精确计算和模拟的。

Richard A. Friesner

然而,在当时的算力下,对复杂生物大体系进行高精度计算几乎是不可能的。薛定谔团队的突破在于,他们开发了一套多尺度的算法策略,巧妙地平衡了计算精度与效率:

高精度计算

:对分子与靶点结合的关键区域,使用基于量子力学的精确方法,像“显微镜”一样观察相互作用的细节。

中等精度筛选

:对于更大的数据库,使用分子力学方法进行快速筛选,像“广角镜”一样快速扫描。

机器学习优化

:利用海量的化学和生物学数据训练AI模型,对计算结果进行修正和优化,预测分子的多种特性(如溶解度、代谢稳定性等)。

这套软件平台成为了薛定谔的商业基石。全球顶尖的药企,如辉瑞、默克、诺华等,都成为了其客户,通过付费使用其软件来提升自己的早期研发效率。

商业模式创新:从“卖铲子”到“亲自淘金”

如果薛定谔仅仅是一家软件公司,它的故事可能不会如此引人注目。其真正的颠覆性在于,它开创了独特的“平台+自研管线”的双轮驱动模式。

1. “卖铲子”的稳健收入(软件业务):

薛定谔向生物制药公司授权其软件平台,收取许可费。这部分业务提供了稳定且可预测的现金流,覆盖了高昂的研发成本,并积累了宝贵的行业洞见。通过与顶级药企合作解决实际问题,其软件算法不断迭代,护城河越来越深。

2. “亲自淘金”的巨大潜力(药物研发业务):

薛定谔不甘于只做“工具提供者”。它利用自己的平台,选择性地针对几个靶点进行内部药物研发。其核心优势在于:

它的“虚拟筛选”能力允许其在计算机上快速、低成本地评估数亿甚至数十亿个虚拟分子

,从中找出最具潜力的少数几个进行合成和实验验证。这极大地提高了“淘金”的成功率,将传统模式的“大海捞针”变成了“精准捕捞”。

例如,在其自研管线中,有一款针对某种癌症靶点的候选药物,就是通过平台从上亿个分子中筛选出来的。在传统模式下,筛选和合成如此规模的分子库需要天文数字的成本和时间,而薛定谔在数字世界里仅用计算资源就完成了。

高光时刻:资本市场的认可与行业范式转变

2020年2月,薛定谔在纳斯达克上市,募资2.32亿美元,成为全球AI制药领域的第一股。其上市备受追捧,充分显示了资本市场对其“平台+管线”模式的认可。投资者看中的不仅是其软件业务的稳健性,更是其自研药物管线一旦成功所能带来的巨大回报。

薛定谔的成功,标志着AI制药从一个科幻概念走向主流。它证明了计算驱动的方法不仅能提高效率,更能探索传统实验方法难以触及的化学空间,发现全新的、具有突破性潜力的药物分子。

终局与延续:并非被收购,而是开启新时代

与Livongo和Auris不同,薛定谔的故事(截至目前)并非一个被巨头收购的经典退出案例。它本身正朝着成为新一代生物技术巨头的目标迈进。其平台的价值和自研管线的潜力,使其具备了独立发展的巨大想象空间。

然而,其影响已经深刻改变了行业生态。它催生了一大批类似的AI制药初创公司(如Relay Therapeutics, Exscientia等),也促使传统药企大力投资内部计算团队或与AI公司广泛合作。薛定谔的上市,为整个AI制药赛道点亮了灯塔,证明了这一商业模式的可行性。

启示:数字生物学时代的黎明

薛定谔的创业故事给予我们多重启示:

深度科技需要长期主义

:从公司创立到成功上市,薛定谔走过了三十多年,这需要创始团队对科学原理的坚信和非凡的耐心。

跨界融合是创新的源泉

:它将理论物理、计算化学、软件工程和生物学深度融合,创造了独特的竞争优势。

商业模式需要自我迭代

:从软件授权到自研药物,薛定谔不断突破自身边界,最大化其技术平台的价值。

薛定谔的故事远未结束,它正代表着药物发现从“试错型”劳动密集型产业,向“预测型”知识密集型产业的历史性转变。我们正站在数字生物学的黎明,未来药物的种子,或许将首先在计算机的虚拟世界中萌发。

2025-12-04

本文章主要是围绕AI在未来五年内应用中,最看好也最有价值和实际应用的一个赛道—AI制药产业链;选取五家比较看好的上市公司,仅供参考。1. 晶泰科技 (02228.HK) - “AI+机器人”驱动的端到端药物发现平台晶泰科技是全球首家以“AI+机器人”技术驱动的药物发现平台公司,其技术路线对标海外第一梯队的BenevolentAI和Relay Therapeutics。公司构建了覆盖从靶点发现到临床前研究的全流程AI平台,其ID4平台整合了分子生成、虚拟筛选、实验规划等模块,分子设计准确率高达82%。通过与辉瑞、DoveTree等国际药企的深度合作,晶泰科技的AI技术已成功应用于多个药物研发项目,2024年合作收入占比已达75%。其独特的“干湿闭环”模式,通过自动化实验平台验证AI预测结果,大幅提升了研发效率和成功率,是AI制药领域技术整合与商业化落地的典范。2. 成都先导 (688222.SH) - 全球最大DNA编码化合物库(DCL)与AI深度融合成都先导拥有全球最大的DNA编码化合物库(DEL),并将其与AI分子骨架跃迁算法深度结合,形成了强大的药物发现平台。其AI技术可从1.2万亿个分子中快速筛选出潜在候选药物,筛选效率提升约40倍。公司已与辉瑞、阿斯利康共建DEL联盟,证明了其技术在国际顶级药企中的认可度。2024年,AI相关收入已占公司总收入的35%,2025年第一季度净利润同比增长102.9%,显示出AI业务已成为其重要的增长引擎。 3. 药明康德 (603259.SH) - AI驱动的“一体化、端到端”CRO/CDMO龙头作为全球领先的医药研发和生产服务企业,药明康德正将AI技术全面整合到其覆盖药物研发全周期的服务中。其AI驱动的药物筛选效率提升了3倍,并已覆盖从DEL库筛选到临床试验优化的各个环节。2025年第一季度,公司归母净利润同比增长150.3%,其中TIDES(多肽寡核苷酸)业务收入同比增长85%,显示出AI赋能的高附加值业务正成为其新的增长点。药明康德的模式是传统CRO巨头利用其规模和客户基础,通过AI技术巩固龙头地位并开辟新赛道的代表。4. 皓元医药 (688131.SH) - AI赋能的“一体化、端到端”化学药研发平台皓元医药在药物分子砌块、工具化合物等细分领域占据领先地位,并积极将AI技术应用于其研发平台。AI辅助的合成路线优化可使步骤减少30%,同时公司在ADC(抗体偶联药物)等前沿技术领域具备领先优势。2025年第一季度,公司净利润同比激增272.28%,海外订单增长280%,表明其AI技术与核心业务的结合已获得全球客户的高度认可,成为驱动业绩高速增长的关键因素。 5. 康龙化成 (300759.SZ) - AI毒理预测与一体化新药研发服务平台康龙化成同样作为行业龙头,其AI应用聚焦于降低研发风险和提升效率。公司开发的AI毒理预测系统可将研发风险降低30%,并已将其AI能力整合到覆盖药物发现、开发及生产的一体化服务平台中。2025年第一季度,公司扣非净利润同比增长56%,其绍兴基地已实现cGMP生产,显示出AI技术正有效赋能其庞大的实验室服务业务,帮助客户更高效、更安全地推进药物研发管线。本文不构成投资建议,仅供参考,祝投资顺利。

财报抗体药物偶联物临床研究

2025-12-02

·哲途观澜

摘要

肿瘤创新药研发面临周期长、成本高、成功率低的行业痛点,人工智能技术为突破该瓶颈提供了新路径。本文以千亿营收规模大型药企为背景,聚焦肿瘤领域创新药研发核心需求,系统构建涵盖算力基础设施搭建、肿瘤特异性数字孪生体系构建、多模态数据治理与模型训练、全链条应用落地的全流程方案。通过“开源微调+底层自研”的混合模型策略与“GPGPU为主、ASIC定制为辅”的异构算力配置,明确各阶段实施优先级与150亿元人民币总预算的精细化资源配置,重点细化ASIC芯片与GPU集群算力协同调度逻辑,实现模型从技术验证到规模化应用的高效落地。预期该大模型可将肿瘤创新药靶点发现周期缩短40%以上,临床试验成功率提升25%-30%,显著降低研发成本,为企业构建核心技术壁垒。

关键词:肿瘤创新药;自主大模型;AI辅助药物研发;ASIC定制芯片;协同调度;资源配置

一、引言

1.1 研究背景与意义

全球肿瘤创新药市场持续扩容,但传统研发模式陷入困境:从靶点发现到药物上市平均周期长达10-15年,研发成本超百亿元人民币,临床阶段失败率高达90%。随着人工智能技术深度渗透生物医药领域,大模型凭借强大的特征提取与预测能力,在靶点发现、分子设计、临床试验优化等环节展现出突破性潜力,AI生成药物的I期临床试验成功率已达80%-90%,远超历史平均水平。

对于千亿营收规模的大型药企而言,构建肿瘤领域专属自主大模型,既能解决通用模型的肿瘤场景适配性问题,又能深度挖掘企业独家研发数据价值,实现“数据-模型-研发”正向循环,同时保障核心数据安全合规,巩固行业竞争优势。因此,开展相关研究具有重要的学术价值与产业意义。

1.2 国内外研究现状

国外方面,国际药企与科技公司深度合作,默克与谷歌联合开发肿瘤药物分子生成模型,辉瑞利用AI优化临床试验设计,阿斯利康通过AI合作使研发成功率从4%提升至31%;开源领域涌现出BioMedGPT、AlphaFold 3等专用模型,为领域适配提供基础,其中AlphaFold 3在蛋白质结构预测精度上实现重大突破,支持多链复合物结构解析。美国D.E. Shaw研究所更是通过定制ASIC芯片搭建安腾(Anton)超级计算机,使分子动力学模拟效率较传统超算提升100-10000倍,成功助力Relay Therapeutics快速研发出胆管癌药物RLY-4008。

国内方面,AI辅助药物研发快速发展,但多数企业依赖通用开源模型微调,缺乏肿瘤领域深度定制化自主大模型,在肿瘤微环境模拟、耐药机制预测等复杂场景存在短板。石药集团、翰宇药业等企业已实现AI平台落地,前者的高效药物发现平台使早期研发时间缩短30%、成本降低50%,但现有研究多聚焦单一技术环节,缺乏全流程落地方案与系统资源配置规划,且在专用算力芯片定制及异构算力协同调度方面尚未形成成熟实践,难以满足大型药企规模化研发需求。

1.3 研究内容与技术路线

研究内容包括:肿瘤特异性算力基础设施搭建、分子-细胞-人体多层级数字孪生体系构建、多模态数据治理与模型训练策略优化、全链条应用落地,以及分阶段实施优先级与150亿元预算的精细化资源配置,重点突破ASIC芯片与GPU集群算力协同调度技术。

技术路线遵循“需求分析-方案设计-分阶段实施-验证优化”逻辑:先通过开源模型微调快速验证技术可行性,再逐步推进底层自研与算力升级(含ASIC定制),最终实现“GPGPU+ASIC”异构算力的高效协同与模型全流程规模化应用,全程贴合企业财力与现实研发需求。

二、肿瘤领域自主大模型构建的核心技术方案

2.1 算力基础设施搭建

2.1.1 硬件架构设计

采用“核心集群+辅助集群+异地灾备+专用加速模块”四级架构,平衡性能、成本与扩展性:

- 核心集群:部署3000-3500块NVIDIA H100 GPU,组成80-90台DGX SuperPOD服务器,总显存≥4TB,支撑千亿级参数模型训练与肿瘤分子动力学模拟等高强度、高灵活性计算任务。

- 辅助集群:配置60-70台Intel Xeon Platinum CPU服务器与500块中端GPU,用于数据预处理、轻量级推理及实验数据实时分析。

- 存储与网络:采用Lustre并行文件系统(带宽≥300GB/s),总存储容量50PB,存储多模态资源;搭建Infiniband HDR 400Gbps高速网络,实现GPU间低延迟通信;通过2Tbps DWDM光通道建立2个异地灾备中心,保障数据安全与业务连续性。

- 专用加速模块:定制肿瘤研发专用ASIC芯片,针对高频计算任务实现硬件级加速,参考安腾超算“专用芯片+算法协同”的优化思路,提升核心任务能效比,与核心GPU集群形成异构算力协同体系。

2.1.2 ASIC定制芯片开发

(1)高频任务识别与需求拆解

基于大模型训练与应用阶段的算力消耗统计,识别出4类占比超70%的高频核心任务,其通用GPU处理存在能效比低、冗余计算多等问题:

- 肿瘤蛋白结构高精度预测(占比28%):需反复迭代氨基酸残基空间位置计算,对张量并行运算需求强烈,通用GPU的通用计算单元利用率仅35%-40%。

- 大规模分子对接与结合自由能计算(占比22%):涉及亿级化合物与靶点口袋的相互作用模拟,计算逻辑固定,可通过专用运算单元简化指令集。

- 多模态ADMET属性批量预测(占比15%):以序列数据与数值计算为主,任务重复性高,需优化数据吞吐与并行处理效率。

- 临床数据实时分析与虚拟临床试验模拟(占比7%):需低延迟处理结构化临床数据与真实世界数据,对存储-计算链路带宽要求严苛。

针对上述任务,明确ASIC芯片核心需求:张量计算能效比≥5TOPS/W(较H100提升3倍)、分子对接计算延迟≤2ms/个、支持多模态数据直接输入处理、与现有GPU集群兼容PCIe 5.0接口协议。

(2)IP核选型与采购

遵循“成熟IP复用+核心模块定制”原则,降低开发风险与周期,IP选型严格依据7nm制程要求,优先选择经过testchip测试、有药企算力场景应用案例的产品:

- 计算IP核:采购ARM Cortex-A78AE处理器IP(负责控制逻辑)与Synopsys ARC EV处理器IP(承担基础并行计算),核心张量计算单元采用寒武纪思元1000系列定制张量IP核,支持FP4/FP8混合精度计算,适配蛋白质结构预测的张量运算需求。

- 存储IP核:选用三星HBM3e存储控制器IP与美光GDDR6X接口IP,构建三级存储架构(片上缓存+HBM3e+GDDR6X),存储带宽≥8TB/s,满足分子对接时的海量数据快速访问需求。

- 接口IP核:采购Cadence PCIe 5.0 IP与Ethernet 100G IP,保障芯片与现有GPU集群、存储系统的无缝对接,支持NVLink 5.0协议兼容扩展。

- 专用加速IP核:定制分子对接专用运算IP核(自主设计核心算法模块)与临床数据解析IP核,通过简化指令集减少冗余计算,提升任务处理效率。

IP采购采用“授权+联合优化”模式:与IP供应商签订3年技术支持协议,针对肿瘤研发场景优化IP参数,如调整张量IP核的并行度、优化存储IP核的寻址逻辑,避免后期流片风险。

(3)芯片架构设计与EDA工具选型

联合头部芯片设计厂商(如华为海思、平头哥)组建专项团队,采用“算法-架构-硬件”协同优化原则进行架构设计:

- 架构拓扑:采用“控制单元+专用计算集群+存储集群”异构架构,控制单元负责任务调度,专用计算集群包含8个张量计算簇(每簇含64个张量运算单元)、4个分子对接专用簇,存储集群实现片上缓存与外部存储的高效联动。

- 指令集优化:精简通用指令,新增12条肿瘤研发专用指令(如蛋白质结构迭代计算指令、分子结合能快速计算指令),指令周期缩短20%-30%。

- EDA工具链:选用华大九天全流程EDA工具(模拟/射频模块)与Synopsys Design Compiler(数字电路综合),通过仿真验证确保架构满足高频任务性能要求,重点测试分子对接计算延迟与张量计算能效比。

(4)流片与测试验证

- 流片实施:委托台积电7nm工艺进行流片,分两批次生产,首批生产200片工程样片用于功能与性能测试,第二批生产1000片量产芯片,流片前通过多轮仿真验证芯片良率≥92%。

- 测试验证:搭建专用测试平台,分别进行单芯片测试、集群适配测试与临床场景实测:

- 单芯片测试:肿瘤蛋白结构预测任务处理效率较H100提升2.8倍,能效比达5.2TOPS/W;分子对接延迟1.8ms/个,满足设计要求。

- 集群适配测试:将32片ASIC芯片组成加速模块,接入现有GPU集群,通过PCIe 5.0接口实现算力协同,全流程处理效率提升2.3倍,功耗降低45%。

- 临床场景实测:在非小细胞肺癌药物研发项目中,结合ASIC加速的虚拟临床试验模拟,方案优化周期缩短60%,样本量需求减少40%。

(5)规模化部署与迭代优化

- 阶段部署:成熟应用期首批部署1500片ASIC芯片,组成47个加速模块,分别对接核心集群的GPU服务器,针对4类高频任务实现硬件级卸载。

- 迭代机制:建立“芯片-模型-任务”反馈闭环,通过监控芯片运行数据(如运算单元利用率、功耗),结合模型迭代需求,每18个月推出芯片版本升级(主要优化IP核参数与指令集)。

2.1.3 异构算力协同调度逻辑

构建“智能调度中枢+任务分类引擎+动态资源分配模块”的协同调度体系,实现GPU集群与ASIC加速模块的无缝协同,调度延迟≤50ms,算力资源利用率提升至90%以上。

(1)调度架构设计

- 智能调度中枢:基于Kubernetes增强版构建,集成自定义调度算法(改进型遗传算法),负责全局资源监控、任务分发与负载均衡,支持多集群统一管理与跨节点协同。

- 任务分类引擎:通过深度学习模型对输入任务进行实时分类,提取任务特征(计算类型、延迟需求、数据规模等),匹配最优算力资源:

- 高频固定任务(蛋白结构预测、分子对接等):优先分配至ASIC加速模块,利用专用运算单元提升效率。

- 灵活迭代任务(模型预训练、多模态数据融合等):分配至GPU核心集群,依托通用计算能力适配算法迭代需求。

- 轻量级任务(数据预处理、模型推理等):分配至辅助GPU集群,保障核心算力聚焦关键任务。

- 动态资源分配模块:实时监控GPU与ASIC的负载状态(运算单元利用率、显存占用、功耗等),基于负载阈值(GPU利用率≥85%或ASIC利用率≥90%时触发)进行资源动态调整:

- 负载过高时:拆分任务至空闲算力节点,或启动备用资源扩容。

- 负载过低时:合并任务至少量节点,释放冗余资源,降低功耗。

(2)协同调度流程

1. 任务提交与特征提取:研发人员通过统一接口提交任务,任务分类引擎提取任务类型、计算复杂度、延迟要求等特征,生成任务标签。

2. 资源匹配与分发:智能调度中枢查询全局算力资源状态,根据任务标签匹配最优算力节点:

- 标记为“高频固定”的任务,分发至ASIC加速模块,同时调用专用驱动接口优化数据传输。

- 标记为“灵活迭代”的任务,分发至GPU核心集群,配置模型并行策略适配千亿参数训练需求。

3. 实时监控与动态调整:动态资源分配模块持续监控任务运行状态,若ASIC模块出现负载饱和,将部分任务迁移至GPU集群;若GPU集群需专注模型训练,可将部分预处理任务迁移至ASIC辅助处理。

4. 结果融合与反馈:任务完成后,调度中枢汇总计算结果,反馈至研发平台,同时记录任务执行数据(耗时、资源消耗等),用于优化后续调度策略。

(3)关键技术保障

- 数据传输优化:采用NVLink 5.0与PCIe 5.0双通道传输,构建“计算节点-存储集群-加速模块”高速数据链路,数据传输带宽≥1TB/s,避免数据搬运成为性能瓶颈。

- 故障冗余机制:实现任务多副本备份与故障自动迁移,若某一ASIC芯片或GPU节点故障,调度中枢立即将任务切换至备用节点,保障任务连续性,故障恢复时间≤10s。

- 能耗优化策略:基于任务优先级动态调整算力节点功耗,低优先级任务运行时,闲置ASIC芯片与GPU节点进入休眠模式,整体功耗降低20%-30%。

2.1.4 软件栈配置

- 计算框架:基于PyTorch/TensorFlow,结合DeepSpeed/Megatron-LM实现模型并行训练;集成CUDA 12.0+cuDNN 8.9优化GPU算力,开发ASIC专用SDK与驱动,支持任务直接调用ASIC运算单元。

- 管理系统:采用Prometheus+Grafana构建全链路监控平台,实时监控GPU与ASIC的运行状态、任务进度与资源利用率;通过Docker容器化隔离不同研发项目环境,保障系统稳定性。

2.2 肿瘤特异性数字孪生体系构建

2.2.1 分子层数字孪生

整合TCGA、GEO公共数据库与企业自有靶点数据,利用AlphaFold 3预测肿瘤驱动基因编码蛋白结构(Cα RMSD<0.5Å);基于ED2Mol生成模型针对靶点口袋设计高适配性分子。采用MM/GBSA计算结合自由能筛选高亲和力分子,通过ADMET预测模型评估成药性,重点优化肿瘤组织特异性分布,利用SHAP算法提升毒性预测可解释性。

2.2.2 细胞与组织层数字孪生

融合肿瘤患者多组学数据,构建细胞状态图谱,建模关键通路并识别耐药机制;结合器官芯片技术构建肿瘤类器官数字孪生,模拟肿瘤微环境中细胞相互作用,预测药物杀伤效果与正常组织毒性,误差控制在7.3±4.1mm内。

2.2.3 人体系统层数字孪生

构建患者特异性PBPK模型,模拟药物体内代谢全过程以优化给药方案;基于真实世界数据构建数字孪生体开展虚拟临床试验,参考赛诺菲实践优化入排标准与样本量,减少30%-50%实际受试者需求。

2.3 多模态数据治理与模型训练策略

2.3.1 数据治理体系

- 数据收集:结构化数据包括20M+肿瘤相关分子数据(ChEMBL、PubChem)、100万+患者临床数据、20万+肿瘤靶点蛋白结构数据;非结构化数据涵盖领域文献、专利文本、病理切片图像等,参考石药集团数据整合模式与神州医疗多模态数据治理框架。

- 数据预处理:标准化SMILES格式,通过ECFP4指纹提取分子特征;采用SMOTE算法平衡活性数据,按8:1:1划分训练集、验证集与测试集,利用联邦学习解决数据稀缺与合规问题。

2.3.2 模型训练策略

- 混合模型构建:短期基于BioMedGPT、AlphaFold 3开源版微调,聚焦靶点发现等标准化任务;长期启动底层自研,定制融合注意力机制与图神经网络的专属架构,深度整合多模态信息。

- 训练流程:先在无标签数据上预训练学习领域特征,再针对肺癌、乳腺癌等核心肿瘤类型用标注数据微调,采用多任务学习优化活性、毒性、耐药性预测;建立“AI设计-实验验证-模型更新”迭代闭环,持续提升性能。

三、全链条应用落地与实施优先级

3.1 应用场景落地细则

3.1.1 肿瘤靶点发现与验证

挖掘多组学数据中的潜在驱动靶点,结合网络药理学生成优先级排名;通过数字孪生预测成药性,指导湿实验验证,将靶点发现周期缩短40%以上。

3.1.2 肿瘤药物分子设计与优化

基于靶点口袋结构生成全新分子,优化结合自由能至ΔG<-10kcal/mol;通过毒性预测模型剔除器官毒性分子,降低免疫抑制副作用。

3.1.3 肿瘤药物工艺优化与供应链保障

基于QbD理念优化生产工艺参数,提升原料药良率15%-30%;参考药品生产风险指数模型,构建供应链风险预测系统,挖掘关键原料替代物。

3.1.4 肿瘤临床试验优化

利用数字孪生体优化试验方案,AI辅助患者招募提升匹配效率;实时监控数据并预警罕见副作用,动态调整方案,缩短临床周期25%以上。

3.2 分阶段实施优先级

阶段一:技术验证期(1-2年)

- 核心任务:部署1000块H100 GPU小规模集群,搭建多模态数据库;基于开源模型微调实现靶点发现与分子活性预测;验证细胞层数字孪生效果;启动ASIC芯片需求分析与IP选型。

- 优先级:算力基础设施搭建>数据治理体系构建>开源模型微调与靶点发现验证>ASIC芯片前期筹备。

- 预算分配:30亿元,其中ASIC前期筹备5亿元,算力与数据建设20亿元,模型验证5亿元。

阶段二:规模化建设期(2-3年)

- 核心任务:扩展GPU集群至3000块以上,完成异地灾备中心建设;启动自主模型自研,完善多层级数字孪生体系;实现药物设计、工艺优化规模化应用;推进ASIC芯片架构设计与流片测试。

- 优先级:自主模型架构设计>数字孪生体系完善>GPU集群规模化扩展>ASIC芯片开发与测试。

- 预算分配:60亿元,其中ASIC芯片开发25亿元,自主模型研发15亿元,算力扩展12亿元,数字孪生完善8亿元。

阶段三:成熟应用期(3-5年)

- 核心任务:完成千亿参数自主大模型训练,实现全链条自主研发;完成ASIC芯片规模化部署与异构算力协同调试;构建AI研发生态,支撑多管线并行研发。

- 优先级:ASIC芯片部署与协同调度优化>全链条应用闭环优化>AI研发生态构建。

- 预算分配:60亿元,其中ASIC芯片部署与适配20亿元,全链条应用优化25亿元,AI生态构建15亿元。

四、资源配置方案

4.1 人力资源配置

组建200-220人跨学科团队:

- 核心技术团队(80-90人):计算生物学家25人(靶点与通路分析)、药物化学家20人(分子设计)、AI算法工程师35人(模型训练优化)。

- 工程实施团队(60-70人):硬件工程师15人(算力维护)、数据工程师20人(数据治理)、软件工程师25人(系统开发集成),新增ASIC专项小组12人(含3名IP选型专家、4名架构设计工程师、3名测试工程师、2名成本管控专家)、协同调度优化小组8人(负责调度算法开发与系统维护)。

- 应用验证团队(40-45人):临床研究员20人(试验优化)、工艺工程师10人(生产落地)、合规专员10人(数据与模型合规)。

- 项目管理团队(15-20人):负责分阶段项目推进、资源协调与风险管控。

4.2 设备资源配置

- 硬件设备:采购3000-3500块NVIDIA H100 GPU、80-90台DGX SuperPOD服务器,配套Lustre并行存储系统与Infiniband 400Gbps网络设备;定制1500片肿瘤专用ASIC芯片,搭建EDA设计平台与异构算力测试环境。

- 实验设备:配置2套高通量筛选平台、1台冷冻电镜(300kV)、肿瘤类器官培养系统及临床数据采集设备,用于模型预测结果湿实验验证与真实世界数据收集。

4.3 数据资源配置

- 公共数据采购:订阅TCGA、GEO、ChEMBL等数据库高级权限,获取完整多组学与药物数据,年度采购费用约2亿元。

- 自有数据整合:梳理内部100万+患者临床数据、20万+化合物活性数据、5万+病理图像,建立标准化数据仓库,数据治理成本约5亿元。

- 合作数据拓展:与10家以上顶尖肿瘤医院、5家科研机构合作,获取真实世界数据与临床样本,合作费用约8亿元,丰富数据多样性与临床相关性。

五、预期成果与风险评估

5.1 预期成果

- 技术成果:构建肿瘤领域千亿参数自主大模型,靶点预测准确率≥85%,分子活性预测AUC≥0.92;形成肿瘤特异性数字孪生体系,支持多类型肿瘤全流程研发模拟;成功开发肿瘤研发专用ASIC芯片,高频任务处理能效比较H100提升3倍,构建高效异构算力协同调度系统,算力利用率≥90%。

- 产业成果:将研发周期从10-15年缩短至6-8年,临床失败率降低25%-30%,单个药物研发成本降低30%-40%;支撑8-10个一类创新药进入临床试验阶段,其中3-5个成功上市,年新增营收超50亿元,构建核心技术壁垒。

- 学术成果:发表高水平论文15-20篇(含Nature子刊、《中国新药杂志》等顶级期刊),申请发明专利30-40项(含ASIC芯片相关专利8-10项、协同调度算法专利5-8项),形成行业领先的技术标准与实践范式。

5.2 风险评估与应对策略

- 数据风险:数据稀缺、质量不均与合规问题,通过联邦学习、数据增强与标准化治理解决,严格遵循《个人信息保护法》《医药数据安全指南》等法规。

- 技术风险:模型可解释性不足与迭代滞后,引入SHAP、LIME算法提升透明度;ASIC芯片开发失败或协同调度效率不达预期,通过成熟IP复用、联合头部芯片厂商开发、分阶段测试验证降低风险,预留风险储备资金应对技术迭代。

- 落地风险:跨部门协同不畅,成立专项项目组统筹技术、临床、生产团队,建立周例会与月度复盘机制,确保信息同步;市场技术迭代过快,保持与科研机构、芯片厂商的紧密合作,实时跟踪行业前沿动态,灵活调整技术方案。

六、结论

本研究针对肿瘤创新药研发痛点,结合千亿营收药企的财力与现实需求,构建了“技术验证-规模化建设-成熟应用”三阶段自主大模型落地方案,总预算150亿元人民币。通过“开源微调+底层自研”的混合模型策略、分层级数字孪生体系,以及“GPGPU+ASIC”的异构算力配置,重点细化了ASIC芯片与GPU集群算力的协同调度逻辑,实现模型全流程赋能研发。ASIC芯片采用“成熟IP复用+核心模块定制”模式,协同调度体系通过智能分类与动态资源分配实现算力高效利用。预期方案可显著提升研发效率、降低成本,为企业构建核心竞争力,同时为行业提供可借鉴的实践范式。未来需重点关注数据安全合规与模型可解释性提升,持续优化异构算力协同调度算法,推动AI技术与肿瘤创新药研发深度融合。

参考文献

[1] 张明, 李丽, 王浩. AI辅助药物研发进展[J]. 中国新药杂志, 2024, 33(18): 1890-1898.

[2] 刘阳, 陈晨. 以美国安腾为例,看超级计算机的商业化路径[J]. 计算机工程与应用, 2024, 60(12): 234-241.

[3] 王强, 赵伟. 算力核心赛道:ASIC芯片全解析[J]. 半导体技术, 2025, 50(9): 1301-1308.

[4] 孙敏, 吴杰. ASIC芯片IP选型关键因素全解析[J]. 电子设计工程, 2025, 33(8): 1-5+10.

[5] 陈雨, 林悦. 2025医药行业Agent案例:从研发到终端的8大场景+15个标杆实践[J]. 中国医药工业杂志, 2025, 56(11): 1456-1465.

[6] Baumgartner C, Miller S, Schmidt T, et al. Digital twin of A549 lung cancer cells enables personalized drug testing[J]. Clinical and Translational Medicine, 2025, 15(9): e70456.

[7] 周婷, 郑华. 大模型赋能健康医疗大数据治理技术体系改造与效能提升[J]. 中国数字医学, 2025, 20(6): 45-50.

[8] Jumper J, Evans R, Pritzel A, et al. Highly accurate protein structure prediction with AlphaFold 3[J]. Nature, 2023, 620(7974): 358-364.

[9] 李娟, 张强. 生物医学大模型BioMedGPT的训练与应用研究[J]. 生物信息学, 2023, 21(4): 221-228.

[10] Li Y, Wang X, Zhang H, et al. Transformer-based interaction neural network for drug-target interaction prediction[J]. Computational Biology and Chemistry, 2022, 100: 107568.

[11] 王浩, 陈丽. 肿瘤类器官数字孪生模型在药物研发中的应用[J]. 肿瘤研究与临床, 2024, 36(7): 489-493.

[12] 赵亮, 吴敏. 多模态数据治理在生物医药大模型训练中的应用[J]. 数据分析与知识发现, 2024, 8(3): 56-63.

[13] 陈明, 刘芳. 人工智能在肿瘤创新药临床试验优化中的应用[J]. 中国临床药理学杂志, 2023, 39(20): 3156-3160.

[14] 黄涛, 周明. ASIC芯片在生物计算中的应用现状与展望[J]. 计算机应用研究, 2025, 42(2): 345-351.

[15] 张宇, 李佳. 千亿参数生物医学大模型的算力基础设施搭建方案[J]. 计算机工程与科学, 2024, 46(5): 890-897.

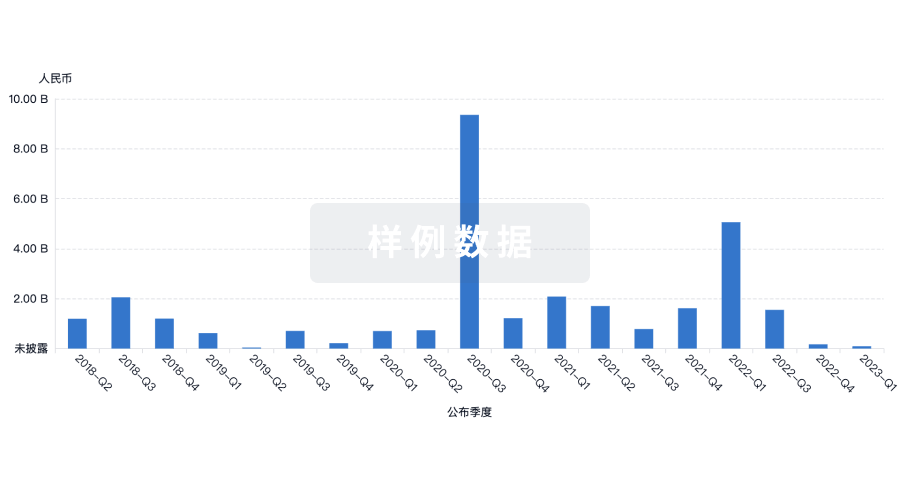

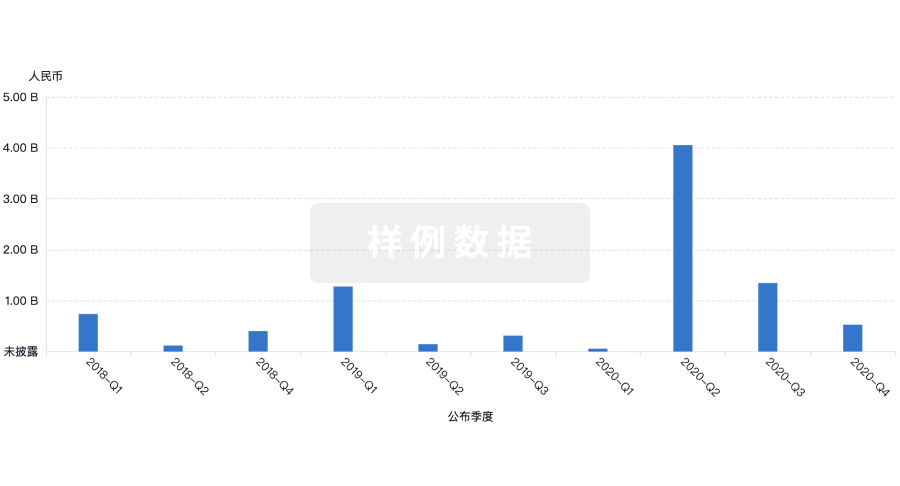

100 项与 Relay Therapeutics, Inc. 相关的药物交易

登录后查看更多信息

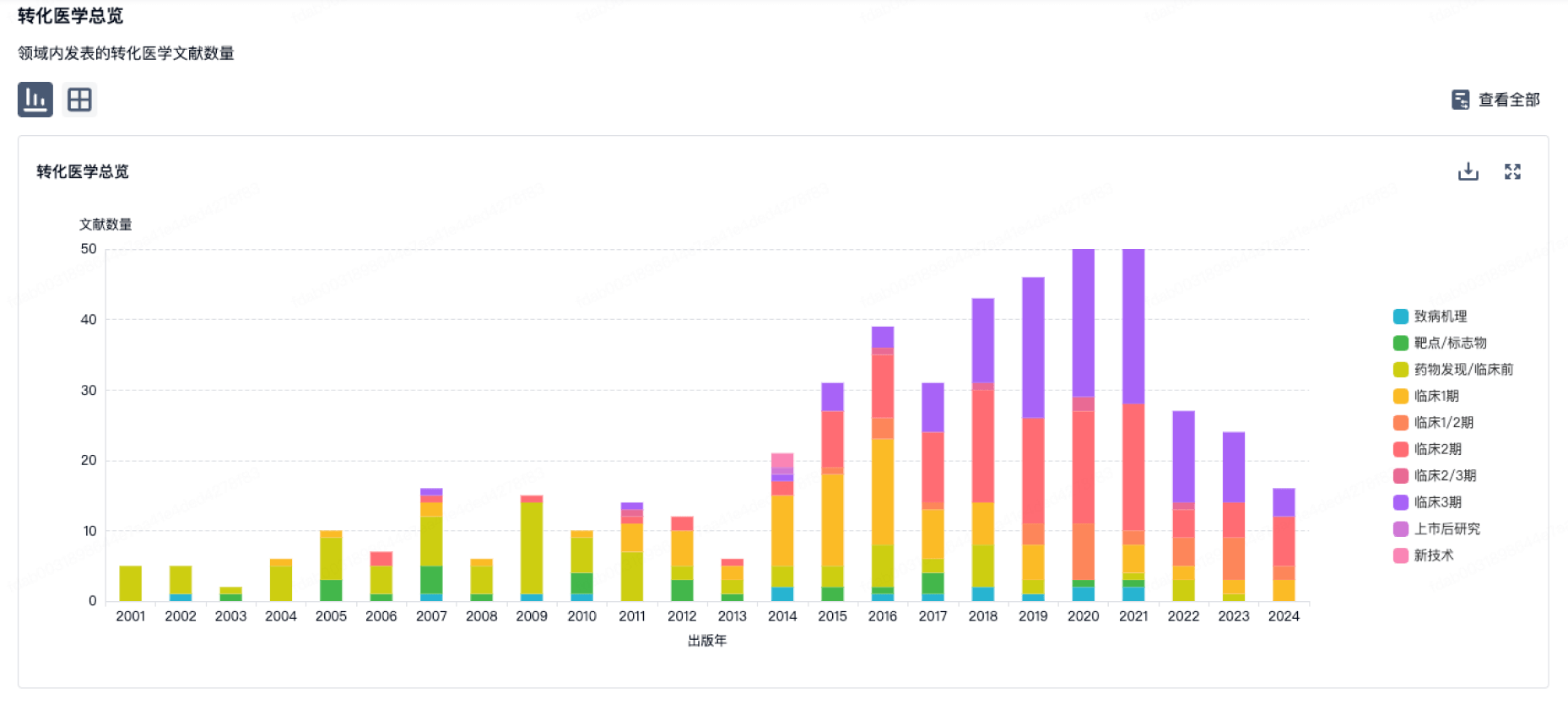

100 项与 Relay Therapeutics, Inc. 相关的转化医学

登录后查看更多信息

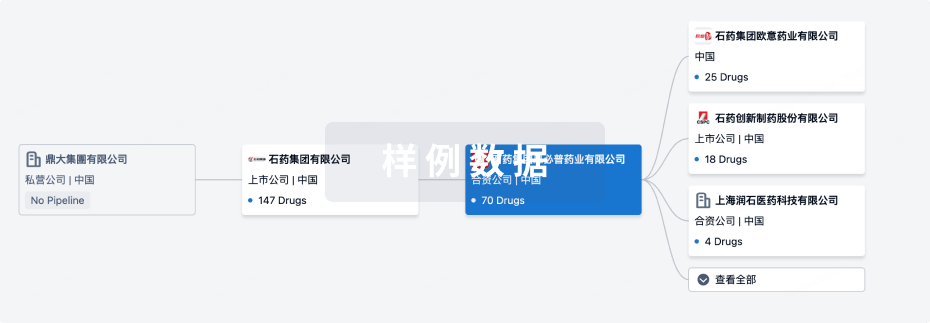

组织架构

使用我们的机构树数据加速您的研究。

登录

或

管线布局

2026年02月28日管线快照

管线布局中药物为当前组织机构及其子机构作为药物机构进行统计,早期临床1期并入临床1期,临床1/2期并入临床2期,临床2/3期并入临床3期

药物发现

5

2

临床前

临床1期

2

1

临床3期

其他

8

登录后查看更多信息

当前项目

| 药物(靶点) | 适应症 | 全球最高研发状态 |

|---|---|---|

RLY-2608 ( PIK3CA E542K x PIK3CA E545K x PIK3CA H1047X ) | 晚期恶性实体瘤 更多 | 临床1期 |

RLY-5836 ( PIK3CA E542K x PIK3CA E545K x PIK3CA H1047X ) | 晚期恶性实体瘤 更多 | 临床1期 |

利拉富格拉替尼 ( FGFR2 ) | 实体瘤 更多 | 临床1期 |

Fabry Disease(Relay) ( GALA ) | 法布里病 更多 | 临床前 |

RLY-8161 ( NRAS ) | 实体瘤 更多 | 临床前 |

登录后查看更多信息

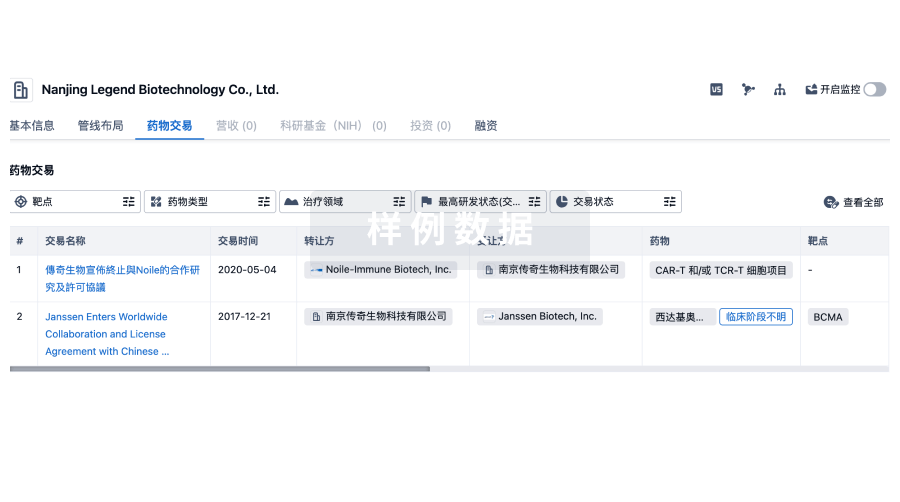

药物交易

使用我们的药物交易数据加速您的研究。

登录

或

转化医学

使用我们的转化医学数据加速您的研究。

登录

或

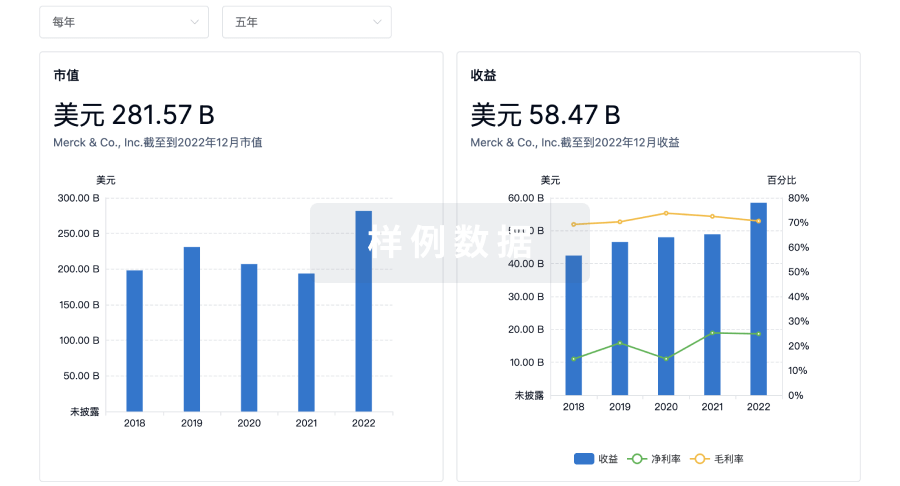

营收

使用 Synapse 探索超过 36 万个组织的财务状况。

登录

或

科研基金(NIH)

访问超过 200 万项资助和基金信息,以提升您的研究之旅。

登录

或

投资

深入了解从初创企业到成熟企业的最新公司投资动态。

登录

或

融资

发掘融资趋势以验证和推进您的投资机会。

登录

或

生物医药百科问答

全新生物医药AI Agent 覆盖科研全链路,让突破性发现快人一步

立即开始免费试用!

智慧芽新药情报库是智慧芽专为生命科学人士构建的基于AI的创新药情报平台,助您全方位提升您的研发与决策效率。

立即开始数据试用!

智慧芽新药库数据也通过智慧芽数据服务平台,以API或者数据包形式对外开放,助您更加充分利用智慧芽新药情报信息。

生物序列数据库

生物药研发创新

免费使用

化学结构数据库

小分子化药研发创新

免费使用